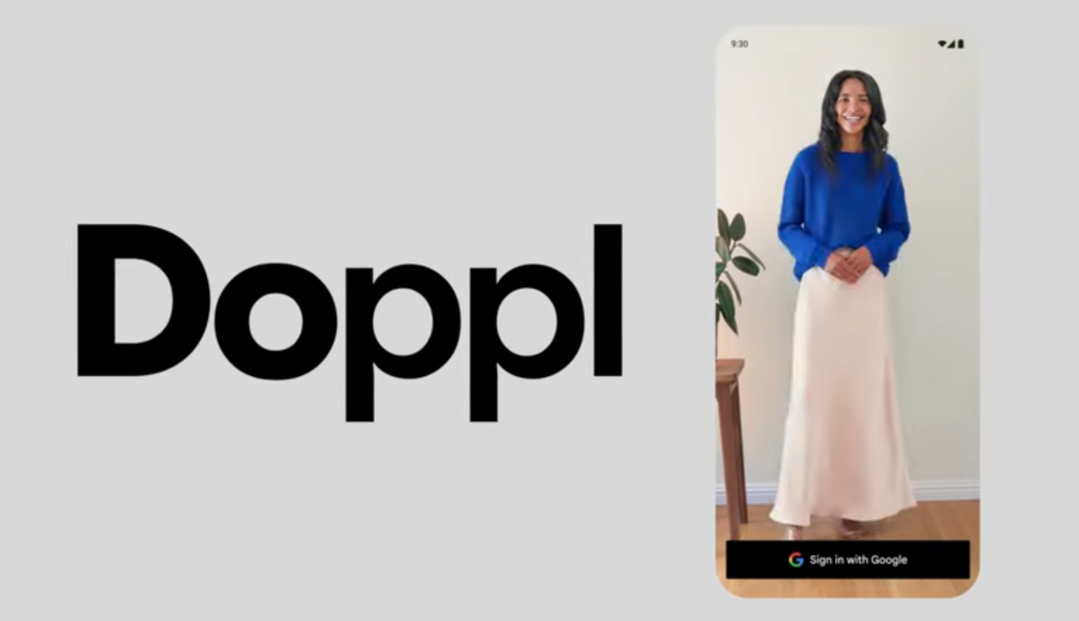

구글이 AI 실험실 ‘Google Labs’를 통해 새로운 스타일 시뮬레이션 앱 Doppl을 공개했다.

이제 사진 한 장만 있으면, 현실에서 직접 입어보지 않아도 옷이 나에게 어울릴지 확인할 수 있는 시대가 열린 것이다. 디지털 아바타가 입은 가상의 옷이, 사용자 고유의 스타일을 찾아가는 도구가 된다.

‘입어보지 않고 입어보기’

2025년 6월 26일, 구글은 AI 기반의 패션 시뮬레이션 앱 Doppl을 미국에서 iOS와 안드로이드 버전으로 정식 출시했다. 이 앱은 사용자가 업로드한 사진이나 스크린샷을 활용해 옷을 ‘가상으로 착용’하는 체험을 제공하며, 정적인 이미지를 AI 기반 동영상으로 변환해 옷의 핏과 움직임을 시각적으로 체험할 수 있게 한다.

Doppl은 지난 5월 Google Shopping이 공개한 “수십억 개의 의류를 내 사진에 입혀보는 기능”을 기반으로, 이를 더 확장한 형태다. 이제는 단순히 정해진 쇼핑몰 이미지가 아니라, 친구가 입은 옷, SNS 속 스타일, 빈티지 상점에서 찍은 사진까지 어떤 이미지든 활용해 나만의 스타일을 가상으로 시도할 수 있게 된 것이다.

AI 영상 합성과 스타일 매핑

Doppl의 핵심 기술은 사용자의 사진을 바탕으로 디지털 아바타를 생성하고, 업로드된 의상 이미지의 형태, 질감, 패턴을 3D 스타일 매핑 및 애니메이션 기술로 시각화하는 것이다. 정적인 사진을 동적으로 재구성해, 단순한 '합성'이 아닌 움직이는 느낌과 핏의 반응까지 반영한다.

이는 기존의 온라인 쇼핑 AR 기술보다 한 단계 발전된 것으로, 패션과 AI 비주얼 기술이 결합된 대표적인 시도다. 특히 DeepMind, Google Research 등의 최신 비전 모델이 적용된 것으로 추정되며, 딥러닝을 활용한 실시간 의상 시뮬레이션 기술이 핵심이다.

사용자들은 친구가 입은 옷이 궁금할 때, SNS에서 본 스타일이 나에게 어울릴지 확인하고 싶을 때, 옷장 속에 있는 아이템을 조합해보고 싶을 때, 즉각적인 스타일 실험 도구로 이 앱을 활용할 수 있다.

앱에선 ‘베스트 룩’을 저장하거나 친구와 공유할 수 있는 기능도 제공한다. 자신만의 디지털 룩북을 만들 수 있는 셈이다. 이는 Z세대가 선호하는 ‘패션 셀프 브랜딩’ 문화와도 밀접하게 닿아 있다.

다만 구글은 이 앱이 아직 실험 단계임을 강조하고 있다. Fit(착용감), 외관, 재질 묘사 등에서 실제 착용과 완전히 일치하지 않을 수 있다는 점을 명확히 밝혔으며, 사용자 피드백을 반영해 지속적으로 기술을 개선해 나갈 계획이다.

Doppl은 구글의 신기술 실험 공간인 Google Labs 소속으로 출시됐으며, 이는 최근 구글이 생성형 AI와 사용자 경험 기술을 결합해 시장 가능성을 탐색하는 테스트베드로 주목받고 있는 라인업이다.

패션의 미래: '착용'보다 '시각화'가 중요해진다

Doppl은 단순한 재미 이상의 의미를 가진다. 소비자가 물리적으로 ‘입어보는 행위’ 없이도, 스타일을 직관적으로 판단하고 선택할 수 있는 감각 기반 쇼핑 경험을 제공하기 때문이다. 패션은 더 이상 '소유'가 아닌, '표현'과 '실험'의 영역으로 이동하고 있으며, Doppl은 이러한 변화의 한가운데 서 있다.

이 앱은 특히 MZ세대, 콘텐츠 크리에이터, 스타일리스트 등 패션을 ‘디지털 언어’로 다루는 집단에게 강력한 도구가 될 수 있다. 더 나아가 디지털 휴먼 기술, 메타버스 아바타 의류 산업, AI 코디 추천 서비스와도 쉽게 연계될 수 있어, 패션 산업의 ‘사용자 중심 기술 전환’을 가속화할 가능성이 크다.

AI는 옷을 ‘입는 방식’ 자체를 바꾸고 있다

Doppl의 등장은 하나의 앱 출시를 넘어, 옷을 고르고 입는 방식 자체가 바뀌고 있음을 보여주는 상징적 사건이다. AI는 이제 단순히 쇼핑을 도와주는 도구를 넘어서, 나 자신을 탐색하고 표현하는 또 다른 창이 되고 있다.

옷을 입기 전에 내가 어떤 사람인지, 어떤 스타일을 원하는지 먼저 확인할 수 있는 시대. 구글의 실험은 지금, 우리 모두의 거울 속 스타일을 새롭게 그리고 있다.

[저작권자ⓒ META-X. 무단전재-재배포 금지]