강화 학습(RL), 모델 수핑(Souping), 상호작용 스케일링을 통한 과학적 논리 및 연산 효율성 극대화

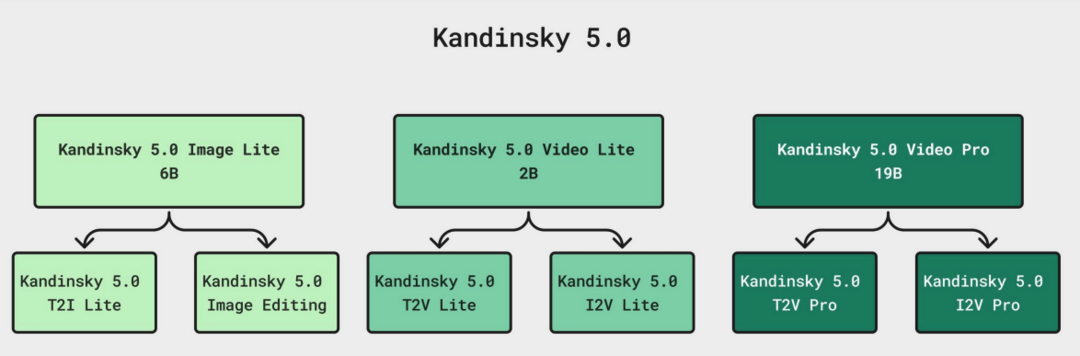

Kandinsky 5.0: A Family of Foundation Models for Image and Video Generation

https://arxiv.org/abs/2511.14993

[메타X(MetaX)] Kandinsky 5.0은 고해상도 이미지와 10초 분량의 비디오 합성을 위한 최신 파운데이션 모델 제품군으로, 6B 파라미터의 Image Lite, 빠르고 가벼운 2B 파라미터의 Video Lite, 그리고 뛰어난 비디오 생성 품질을 자랑하는 19B 파라미터의 Video Pro 등 세 가지 핵심 모델로 구성된다. 이 연구는 데이터 수집부터 필터링, 클러스터링에 이르는 전체 데이터 큐레이션 과정을 포괄적으로 검토하고, 자기 지도 미세 조정(SFT) 및 강화 학습(RL) 기반 사후 학습과 같은 품질 향상 기술을 적용한 다단계 훈련 파이프라인을 소개한다. 또한 새로운 아키텍처와 추론 최적화를 통해 높은 생성 속도와 성능을 달성했음을 입증하며, 연구 커뮤니티의 발전을 위해 코드와 훈련 체크포인트를 오픈 소스로 공개하여 광범위한 생성형 애플리케이션에 활용될 수 있도록 지원한다.

MiroThinker: Pushing the Performance Boundaries of Open-Source Research Agents via Model, Context, and Interactive Scaling

https://arxiv.org/abs/2511.11793

MiroThinker v1.0은 도구 활용 추론과 정보 탐색 능력을 향상시키기 위해 설계된 오픈 소스 연구 에이전트로, 기존 모델들이 모델 크기나 컨텍스트 길이 확장에만 집중했던 것과 달리 에이전트와 환경 간의 상호작용 확장을 세 번째 성능 향상 차원으로 제시한다. 이 모델은 강화 학습을 통해 환경 피드백과 외부 정보 획득을 활용하여 오류를 수정하고 경로를 개선하는 '상호작용 스케일링'을 구현했으며, 256K 컨텍스트 윈도우 내에서 최대 600회의 도구 호출을 수행하여 복잡한 실제 연구 워크플로우를 처리할 수 있다. GAIA 등 4개 벤치마크에서 GPT-5-high와 같은 상용 모델에 근접하는 성능을 보여주며, 모델 용량과 컨텍스트 길이를 보완하는 상호작용의 깊이가 차세대 연구 에이전트 구축의 핵심 요소임을 입증한다.

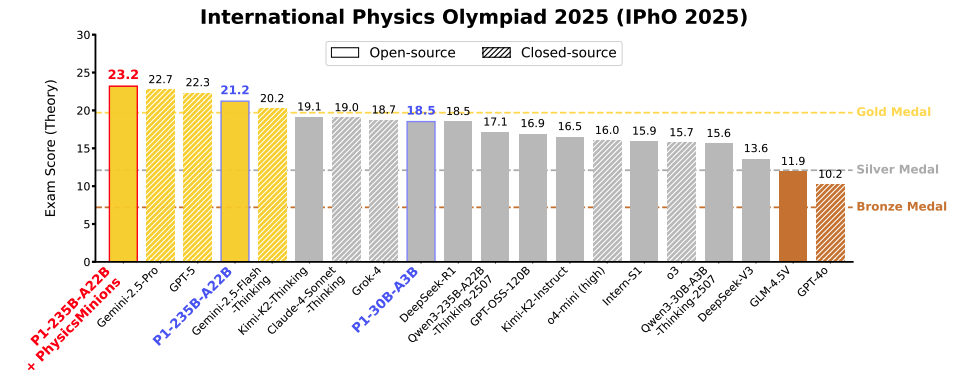

P1: Mastering Physics Olympiads with Reinforcement Learning

https://arxiv.org/abs/2511.13612

P1은 퍼즐 풀이 수준을 넘어 과학적 추론 능력을 갖춘 대규모 언어 모델(LLM)을 목표로 개발되었으며, 오직 강화 학습(RL)만을 통해 훈련된 오픈 소스 물리 추론 모델 제품군이다. 특히 P1-235B-A22B 모델은 2025년 국제 물리 올림피아드(IPhO)에서 금메달 수준의 성능을 기록한 최초의 오픈 소스 모델이며, PhysicsMinions라는 에이전트 프레임워크와 결합하여 전체 1위를 차지하는 등 압도적인 성과를 거두었다. 이러한 P1 모델들은 물리뿐만 아니라 수학이나 코딩 같은 다른 추론 작업에서도 뛰어난 일반화 성능을 보여주며, 기호와 현실을 연결하는 고도화된 물리 문제 해결 능력을 통해 AI의 과학 연구 가능성을 크게 확장한다.

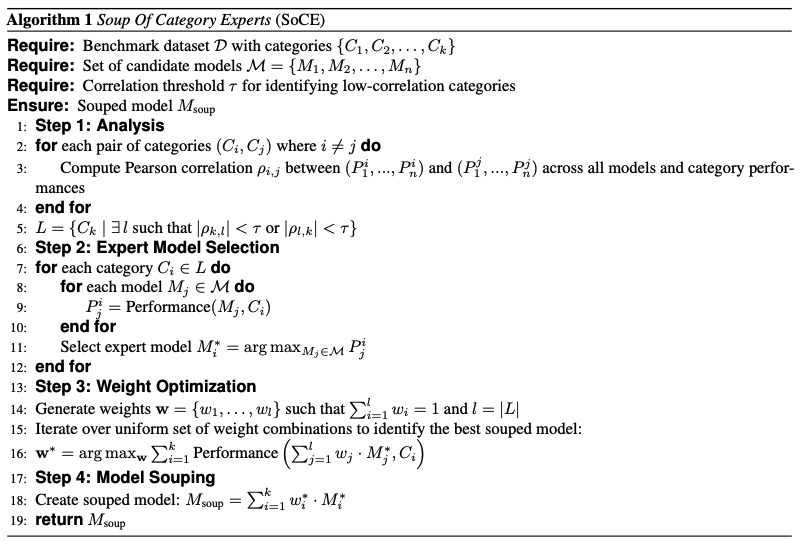

Souper-Model: How Simple Arithmetic Unlocks State-of-the-Art LLM Performance

https://arxiv.org/abs/2511.13254

Souper-Model 연구는 동일한 아키텍처를 가진 여러 모델의 가중치를 평균화하는 '모델 수핑(Model Souping)' 기법을 개선하여, 재학습 없이도 LLM 성능을 높이는 SoCE(Soup Of Category Experts)라는 새로운 접근 방식을 제안한다. 기존의 단순 균일 평균 방식과 달리, 벤치마크 카테고리 간의 상관관계를 분석하여 각 분야의 '전문가' 모델을 식별하고 최적화된 비균일 가중치로 결합함으로써 성능을 극대화한다. 이 방법은 다국어 능력, 도구 호출, 수학 등 다양한 도메인에서 견고한 성능 향상을 입증했으며, 특히 버클리 함수 호출 리더보드에서 최고 수준의 결과를 달성하여 단순한 산술적 결합만으로도 모델 성능을 획기적으로 개선할 수 있음을 보여준다.

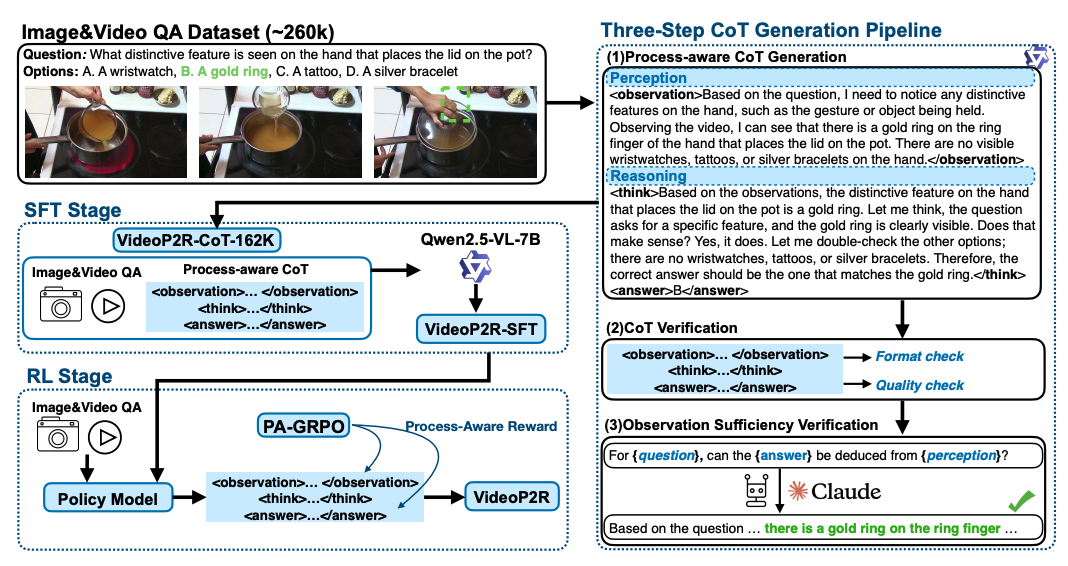

VIDEOP2R: Video Understanding from Perception to Reasoning

https://arxiv.org/abs/2511.11113

VideoP2R은 대규모 비디오 언어 모델(LVLM)의 추론 능력을 향상시키기 위해 '인식'과 '추론'을 별개의 과정으로 모델링하는 새로운 프로세스 인지형 강화 미세 조정(RFT) 프레임워크다. 연구진은 감독 미세 조정(SFT) 단계에서 고품질의 인식 및 추론 연쇄 사고(CoT) 데이터셋을 구축하고, 강화 학습(RL) 단계에서는 인식과 추론에 대해 개별적인 보상을 제공하는 PA-GRPO 알고리즘을 도입했다. 이를 통해 7개의 비디오 추론 벤치마크 중 6개에서 최고 성능(SotA)을 달성했으며, 모델의 인식 출력이 다운스트림 추론에 충분한 정보를 제공함을 입증하여 비디오 이해 분야에서 프로세스 분리 접근법의 유효성을 확인시켜 준다.

Uni-MoE-2.0-Omni: Scaling Language-Centric Omnimodal Large Model with Advanced MoE, Training and Data

https://arxiv.org/abs/2511.12609

Uni-MoE 2.0은 언어 중심의 다중 모달 이해, 추론 및 생성을 위한 완전 오픈 소스 옴니모달 대규모 모델(OLM)로, 동적 용량의 전문가 혼합(MoE) 설계와 점진적 학습 전략을 통해 구축되었다. 이 모델은 텍스트, 이미지, 음성을 아우르는 옴니모달 이해 능력뿐만 아니라 이미지와 음성 생성 기능까지 갖추고 있으며, 10가지 교차 모달 입력에 대해 계산 효율성과 성능의 균형을 맞춘 새로운 아키텍처를 적용했다. 85개 벤치마크에서의 광범위한 평가 결과, 비디오 이해와 시청각 추론 등에서 기존 선도 모델인 Qwen2.5-Omni를 능가하는 성능을 기록하여 오픈 소스 멀티모달 모델의 새로운 기준을 제시한다.

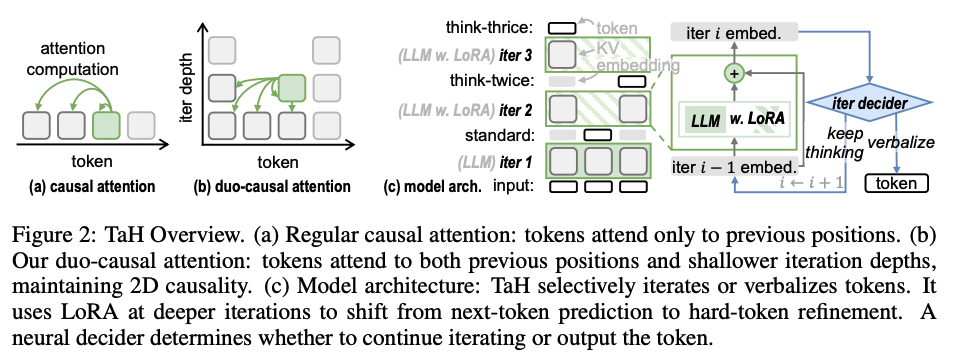

Think-at-Hard: Selective Latent Iterations to Improve Reasoning Language Models

https://arxiv.org/abs/2511.08577

Think-at-Hard(TaH)는 LLM의 추론 능력을 높이기 위해 모든 토큰에 대해 추가 연산을 수행하는 대신, 어렵다고 판단되는 토큰에서만 잠재적 반복(latent iteration)을 깊게 수행하는 동적 사고 방식이다. 연구진은 쉬운 토큰을 과도하게 수정하다가 오히려 오류가 발생하는 '잠재적 과잉 사고' 현상을 발견하고, 경량 신경망 결정기를 통해 추가 연산이 필요한 시점을 선별적으로 결정하도록 설계했다. 이 방식은 LoRA 모듈과 이중 인과 주의(duo-causal attention) 메커니즘을 활용하여 94%의 토큰에 대해서는 추가 연산을 생략하면서도 추론 정확도를 8~12% 향상시켜, 파라미터 증가를 최소화하면서 효율적으로 모델 성능을 최적화한다.

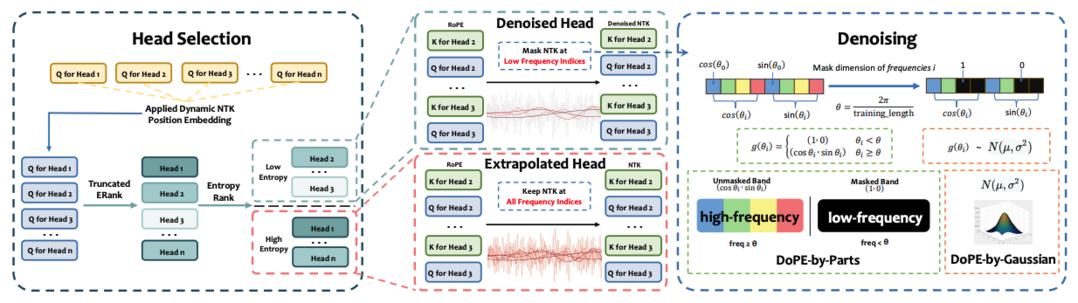

DoPE: Denoising Rotary Position Embedding

https://arxiv.org/abs/2511.09146

DoPE(Denoising Rotary Position Embedding)는 트랜스포머 모델의 위치 임베딩(RoPE)이 가진 길이 확장성의 한계를 극복하기 위해 제안된 훈련이 필요 없는 방법론이다. 연구진은 위치 인코딩이 적용된 어텐션 맵을 노이즈가 있는 특징 맵으로 재해석하고, 절단된 행렬 엔트로피를 기반으로 이상 주파수 대역을 제거(denoising)하여 '어텐션 싱크' 현상을 완화했다. 이를 통해 최대 64K 토큰까지 문맥 길이가 확장된 상황에서도 검색 정확도와 추론 안정성을 크게 향상시켰으며, 위치 임베딩의 노이즈 제거가 모델의 길이 일반화 성능을 높이는 간단하면서도 강력한 해결책임을 보여준다.

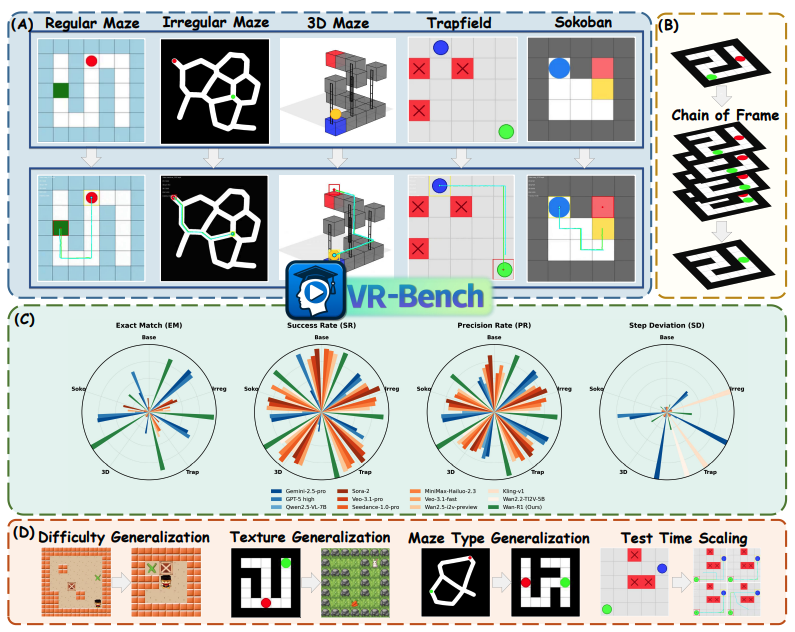

Reasoning via Video: The First Evaluation of Video Models' Reasoning Abilities through Maze-Solving Tasks

https://arxiv.org/abs/2511.15065

이 연구는 비디오 생성 모델이 텍스트 모델처럼 추론 능력을 가질 수 있는지 탐구하며, 이를 체계적으로 평가하기 위해 미로 찾기 작업에 기반한 VR-Bench를 소개한다. 7,920개의 절차적으로 생성된 비디오로 구성된 이 벤치마크를 통해, 연구진은 비디오 모델이 감독 미세 조정(SFT)을 거치면 공간적 계획과 다단계 추론이 필요한 작업에서 뛰어난 공간 지각 능력을 발휘함을 확인했다. 특히 추론 시 다양한 샘플링을 수행하는 테스트 시간 스케일링(test-time scaling)이 추론 신뢰도를 10~20% 향상시킨다는 사실을 발견하여, 비디오 생성을 통한 공간 추론의 확장성과 잠재력을 입증한다.

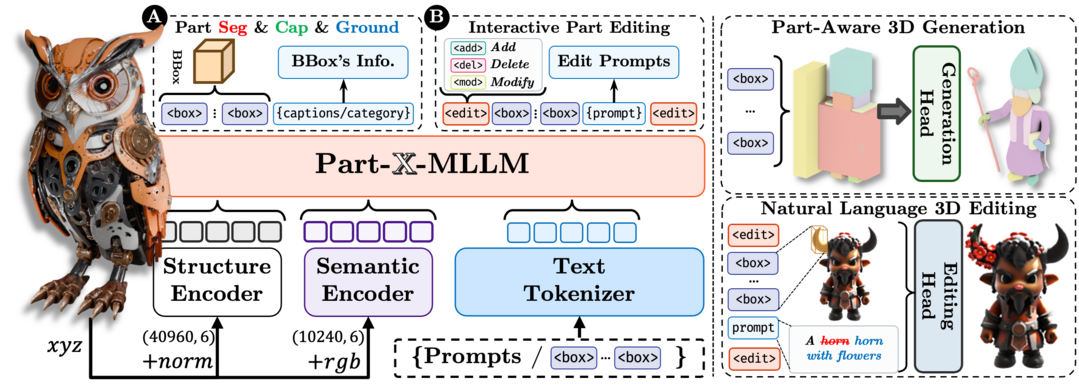

Part-X-MLLM: Part-aware 3D Multimodal Large Language Model

https://arxiv.org/abs/2511.13647

Part-X-MLLM은 다양한 3D 작업을 구조화되고 실행 가능한 문법으로 통합하여 처리하는 기본 3D 멀티모달 대규모 언어 모델이다. 이 모델은 RGB 포인트 클라우드와 자연어 프롬프트를 입력받아 부품 수준의 바운딩 박스, 의미 설명, 편집 명령 등을 포함하는 일관된 토큰 시퀀스를 생성하며, 이를 통해 기하학적 합성 엔진을 제어한다. 상징적 계획과 기하학적 합성을 분리함으로써 단일 인터페이스로 고품질의 구조화된 계획을 수립할 수 있게 되었으며, 근거 있는 질의응답(Q&A), 구성적 생성, 국소 편집 등 다양한 3D 작업에서 최신 성능을 달성한다.

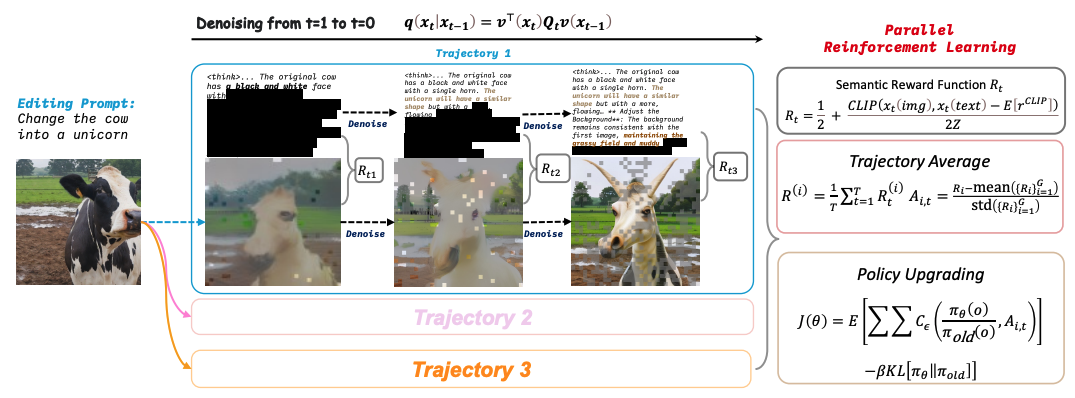

MMaDA-Parallel: Multimodal Large Diffusion Language Models for Thinking-Aware Editing and Generation

https://arxiv.org/abs/2511.09611

MMaDA-Parallel은 복잡한 이미지 생성 작업에서 기존의 순차적 접근 방식이 오류 전파로 인해 성능이 저하되는 문제를 해결하기 위해 제안된 병렬 멀티모달 확산 프레임워크다. 텍스트와 이미지 모달리티가 디노이징(denoising) 과정 전체에서 지속적이고 양방향으로 상호작용하도록 설계되었으며, 교차 모달 일관성을 강화하기 위해 의미적 보상을 적용하는 병렬 강화 학습(ParaRL) 전략을 도입했다. 이를 통해 생성된 추론 내용과 최종 이미지 간의 정렬 불일치 문제를 크게 개선하였으며, ParaBench 벤치마크에서 기존 최신 모델보다 높은 정렬 성능을 기록하여 사고 인지형 이미지 합성의 새로운 패러다임을 제시한다.

[METAX = 김한얼 기자]

[저작권자ⓒ META-X. 무단전재-재배포 금지]