119개 언어와 방언을 지원하는 글로벌 범용성

프로그래밍 및 에이전트(Agent) 능력 강화

알리바바 산하 Qwen 팀이 4월 29일, 차세대 대형 언어 모델 Qwen3를 공식 발표했다.

이번 모델은 ‘더 깊게 사고하고, 더 빠르게 행동하라(Think Deeper, Act Faster)’는 슬로건을 내세우며, 기존 AI 모델들과 차별화된 기술적 혁신을 대거 탑재했다.

특히 주목할 점은 세 가지다. ▲사용자가 스스로 AI의 사고 깊이를 조정할 수 있는 ‘하이브리드 사고 시스템’, ▲119개 언어와 방언을 지원하는 글로벌 범용성, ▲그리고 프로그래밍 및 에이전트(Agent) 기능을 대폭 강화한 점이다.

Qwen3의 출시는 단순히 모델 성능을 높이는 수준을 넘어, AI의 사고 과정을 인간이 직접 통제할 수 있는 시대가 열렸음을 알리는 신호탄으로 평가된다.

사고를 조정할 수 있는 AI: ‘Thinking’과 ‘Non-Thinking’의 공존

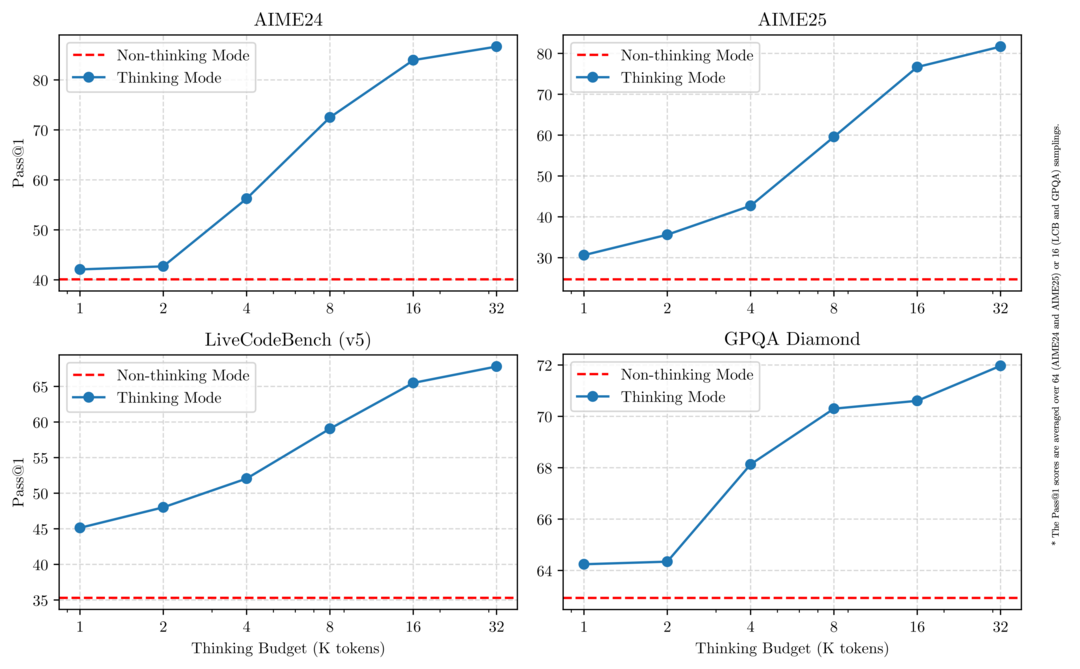

Qwen3가 가장 먼저 주목받는 이유는 바로 ‘하이브리드 사고 모드’ 기능이다. 이제 사용자는 상황에 따라 AI가 깊은 사고를 거쳐 답변할지, 또는 즉각 빠르게 답변할지를 스스로 선택할 수 있다.

예를 들어, 복잡한 수학 문제나 논리적 사고가 필요한 경우에는 'Thinking Mode'를 활성화해

모델이 단계별로 추론을 거친 뒤 답변을 생성하게 할 수 있다. 반면 단순 정보 조회나 가벼운 질문처럼 속도가 중요한 상황에서는 'Non-Thinking Mode'를 통해 지연 없이 빠른 답변을 얻을 수 있다.

또한, 사용자는 대화 중 프롬프트에 /think 또는 /no_think 명령어를 삽입함으로써, 대화 흐름에 따라 사고 모드를 실시간으로 전환할 수 있다. 이는 AI 활용 비용(컴퓨팅 자원)과 응답 품질 사이에서 상황에 맞는 최적의 균형을 찾을 수 있도록 돕는 강력한 기능이다.

결국 Qwen3는 단순히 "답변을 생성하는 AI"를 넘어, ‘어떤 방식으로 사고할지’까지 설계할 수 있는 AI라는 새로운 패러다임을 제시한 셈이다.

전 세계를 연결하는 119개 언어·방언 지원

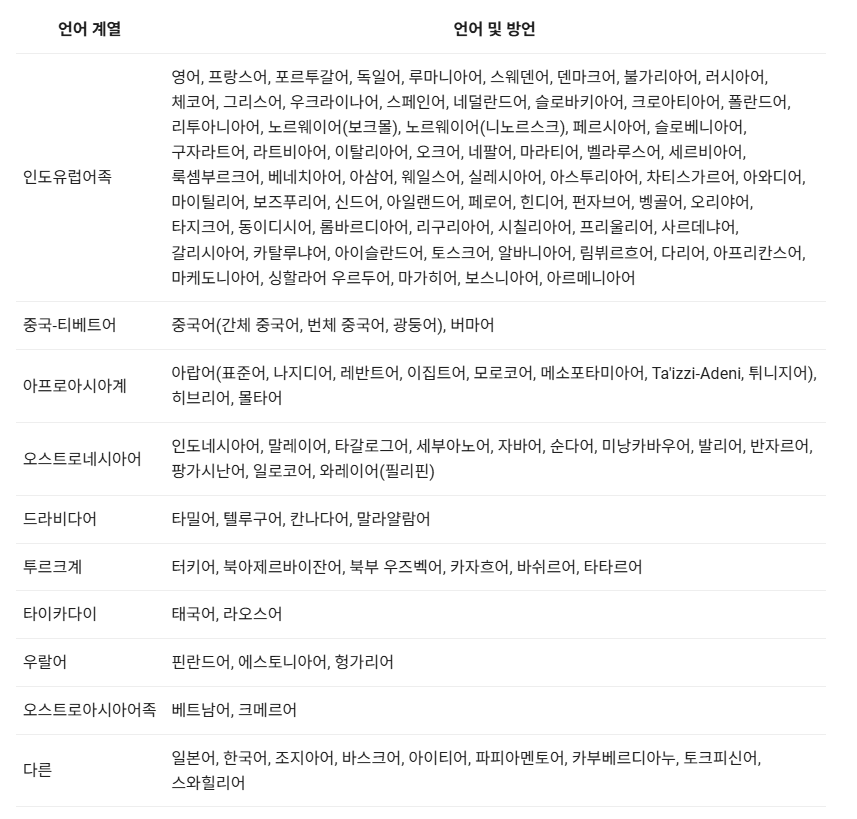

Qwen3는 영어, 중국어, 일본어, 한국어를 포함해 총 119개 언어와 방언을 지원한다. 이는 단순한 언어 번역 기능을 넘어, 다문화권 사용자와의 자연스러운 소통을 목표로 설계된 점이 특징이다.

지원 언어는 인도-유럽어족, 시노-티베트어족, 아프리카-아시아어족, 오스트로네시아어족 등 세계 주요 언어군은 물론, 웰시어, 신할라어, 바스크어 등 소수 언어까지 폭넓게 아우른다.

이러한 다국어 지원 능력은 Qwen3가 진정한 글로벌 AI 에이전트로 자리잡을 수 있는 기반을 마련하며, 국가와 지역을 초월한 다양한 비즈니스, 연구, 커뮤니케이션 분야에서 활용 가능성을 대폭 확장시킬 전망이다.

프로그래밍과 에이전트(Agent) 능력 강화

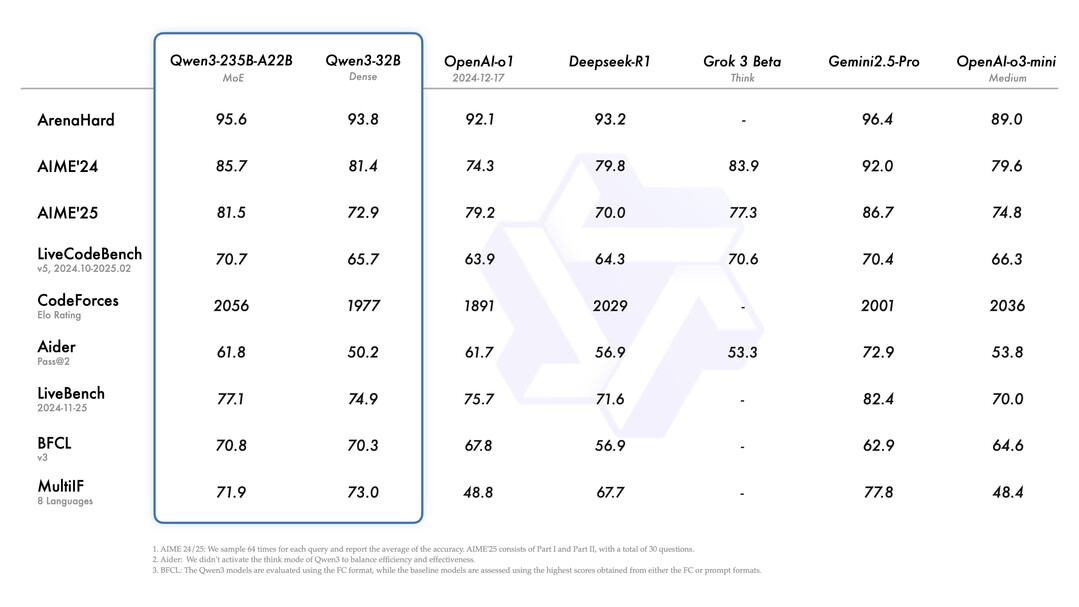

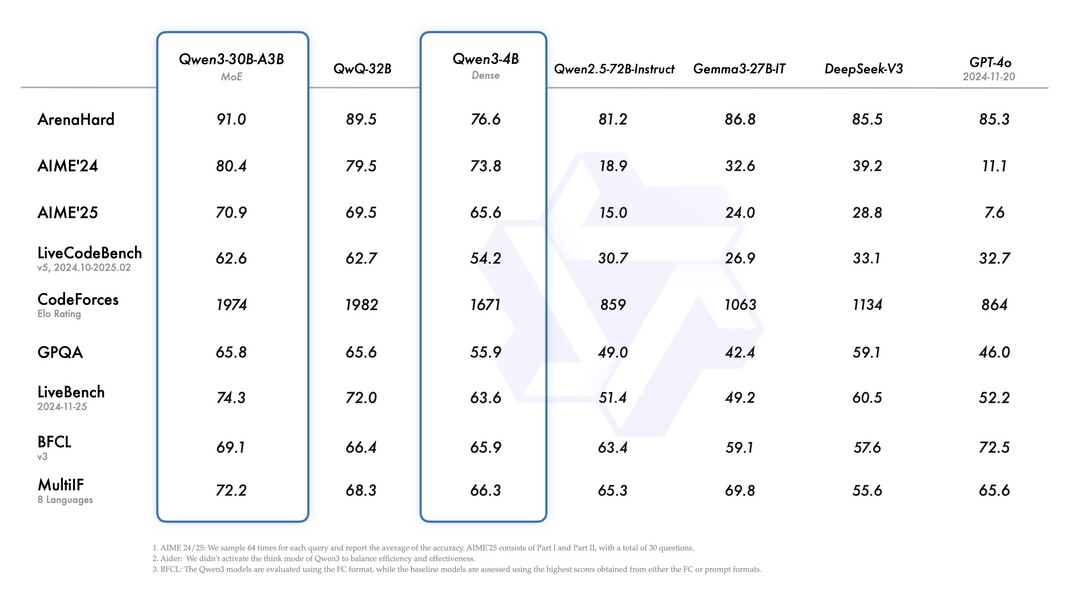

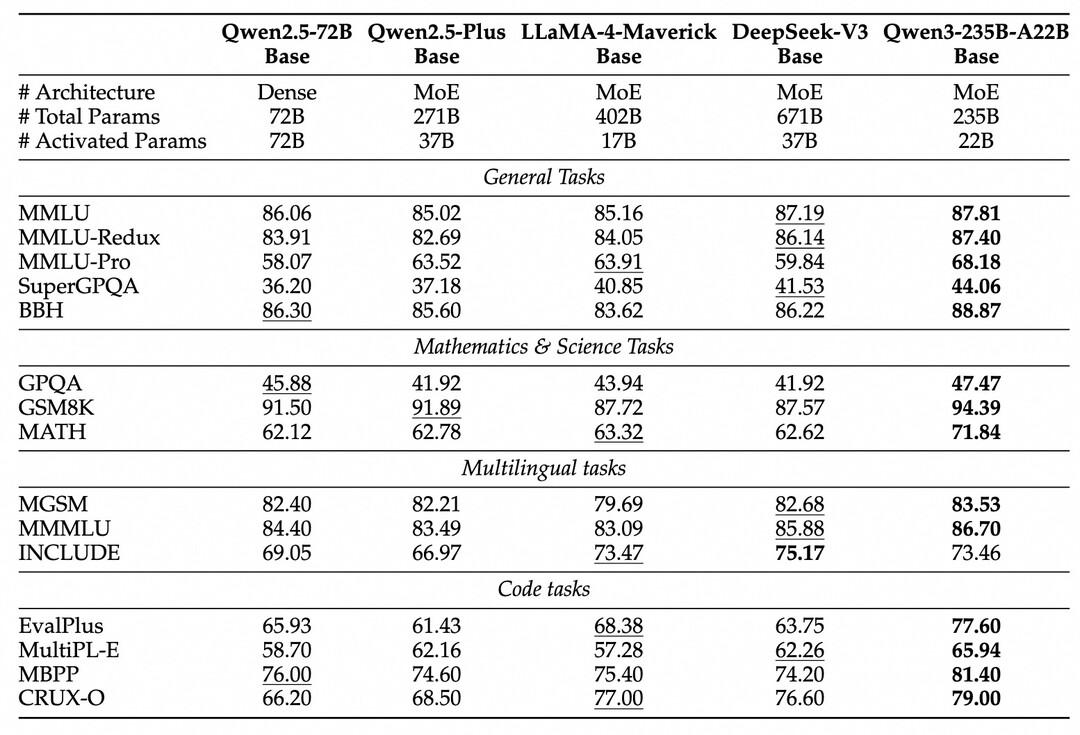

Qwen3는 프로그래밍과 에이전트 기능에서도 뚜렷한 진화를 이뤄냈다. 모델은 코드 작성, 오류 수정, 복잡한 수학 문제 해결 등 기존 Qwen2.5 대비 월등한 성능을 보여준다.

특히 ‘Qwen-Agent’라는 통합 프레임워크를 통해, AI가 외부 도구를 능동적으로 호출하고 복잡한 작업을 스스로 처리할 수 있게 됐다.

예를 들어, 시간 서버에 접속해 현재 시간을 가져오거나, 외부 인터넷 데이터를 실시간으로 조회하고 가공하는 등 다양한 실질적 작업을 자동화할 수 있다.

Qwen 팀은 이를 두고 “AI가 단순히 대화를 주고받는 수준을 넘어, 실질적인 ‘작업 수행 에이전트’로 진화하고 있다”고 강조했다.

이는 향후 Qwen3가 기업용 자동화, 스마트 에이전트 개발, 복합적 업무 처리 분야에서 폭넓은 응용 가능성을 지닌다는 것을 시사한다.

학습 데이터 2배, 문맥 길이 4배: 사전학습의 대도약

Qwen3는 학습 데이터와 사전학습 과정에서도 대대적인 진화를 이뤄냈다. 이전 모델인 Qwen2.5가 약 18조 개 토큰을 학습한 데 비해, Qwen3는 36조 개 토큰이라는 두 배 규모의 데이터를 활용해 훈련됐다.

학습 데이터는 웹 문서에만 국한되지 않았다. PDF와 같은 비정형 문서에서도 텍스트를 추출해 학습에 반영했으며, 수학 문제와 코딩 데이터는 자체 합성(Synthetic Generation) 기법을 통해 대량으로 추가 확보해 전문성을 강화했다.

문맥 길이 역시 기존 4,000 토큰 수준에서 32,000 토큰까지 대폭 확장됐다. 이를 통해 Qwen3는 긴 문서, 복잡한 다중 질의응답, 긴 대화 흐름도 끊김 없이 자연스럽게 처리할 수 있는 능력을 갖추게 됐다.

이러한 학습 규모와 문맥 처리 능력의 향상은 Qwen3가 단순한 지식 응답형 AI를 넘어, 복잡한 사고와 고차원적 문제 해결이 가능한 AI로 도약했음을 보여준다.

사고를 훈련하다: 4단계 후훈련(Post-training) 프로세스

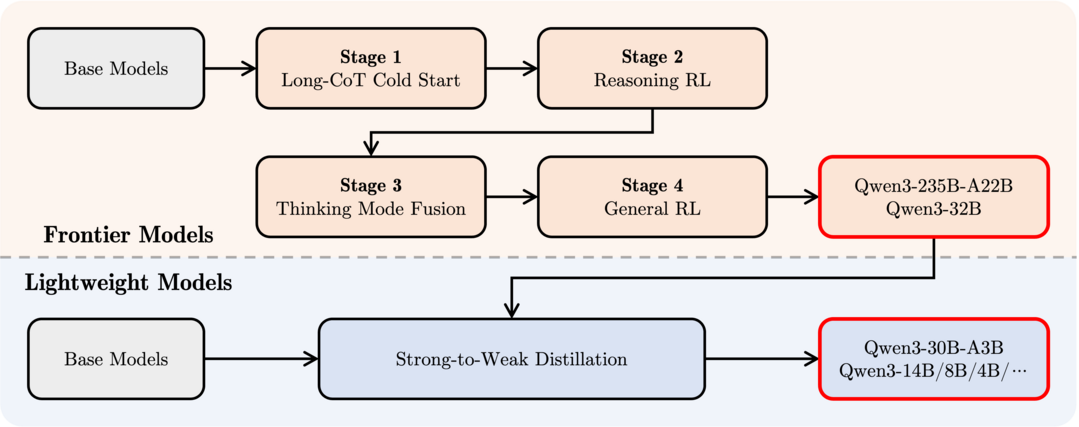

Qwen3가 단순한 답변 생성기를 넘어설 수 있었던 비결은, 체계적인 4단계 후훈련(Post-training) 과정에 있다.

첫 번째 단계에서는 다양한 분야의 긴 Chain-of-Thought(CoT) 데이터를 학습했다. 이를 통해 수학, 코딩, 논리 문제 등에서 기초적인 단계별 추론 능력을 구축했다.

두 번째 단계에서는 강화학습(RL)을 적용했다. 모델이 스스로 다양한 상황을 탐색하고 최적의 답변 경로를 찾을 수 있도록 설계해, 추론의 깊이와 정확성을 크게 향상시켰다.

세 번째 단계에서는 사고 모드(Thinking)와 비사고 모드(Non-Thinking)를 통합했다. 덕분에 Qwen3는 상황에 따라 자연스럽게 사고 방식을 전환하며, 속도와 깊이를 자유롭게 조정할 수 있게 됐다.

마지막 네 번째 단계에서는 20개 이상의 일반 과제(Instruction Following, Format Following 등)를 대상으로 추가적인 RL을 실시해, 전방위적 작업 수행 능력과 일관된 행동 품질을 다듬었다.

이러한 후훈련 과정을 통해 Qwen3는 그저 대답을 제공하는 수준을 넘어, 문제를 스스로 분석하고, 상황에 맞는 사고 흐름을 선택할 줄 아는 AI로 진화했다.

누구나 쉽게 사용하고, 손쉽게 배포할 수 있다

Qwen3는 완전한 오픈소스 모델로 공개됐다. 사용자는 Hugging Face, ModelScope, Kaggle 등 주요 플랫폼을 통해 자유롭게 모델 파일에 접근하고 활용할 수 있다.

로컬 환경에서는 Ollama, LMStudio, llama.cpp 등 다양한 도구를 통해 간편하게 모델을 실행할 수 있으며, 보다 전문적인 서버 구축이 필요한 경우에는 sglang이나 vLLM 프레임워크를 이용해 OpenAI API와 호환되는 엔드포인트를 손쉽게 세팅할 수 있다.

프로그래밍 경험이 없는 초보자도, 공식 제공되는 간단한 예제 코드를 통해 대화형 챗봇, 개인용 AI 에이전트 등을 손쉽게 만들어볼 수 있도록 설계된 점 역시 특징이다.

Qwen3는 ‘오픈’이라는 가치를 실천하며, 모든 개발자와 기업이 AI를 쉽게 활용할 수 있는 길을 열어주고 있다.

AGI를 향한 중간 기착지

Qwen 팀은 Qwen3를 AGI(Artificial General Intelligence, 범용 인공지능)와 ASI(Artificial Superintelligence, 초지능)를 향한 중간 기착지(milestone)로 정의했다. 팀은 앞으로 다음과 같은 방향으로 모델을 지속적으로 발전시킬 계획을 밝혔다.

데이터 규모와 모델 파라미터 수의 지속적 확장

문맥 길이를 128K 이상으로 확장해 초장기 대화 및 복잡한 문서 처리 가능

텍스트뿐만 아니라 이미지, 음성 등 멀티모달 데이터 통합

환경 피드백을 반영한 장기 추론(Long-horizon reasoning) 강화

특히 Qwen 팀은 "우리는 이제 모델을 훈련하는 시대를 넘어, 에이전트를 훈련하는 시대로 전환하고 있다"고 강조했다.

이는 AI가 단순한 언어 생성기를 넘어, 능동적으로 환경과 상호작용하며 문제를 해결하는 존재로 진화할 것임을 시사하는 대목이다.

이제 사용자는 AI에게 명령을 내릴 뿐 아니라, 어떻게 사고할 것인지를 직접 설정하고, 필요에 따라 사고 깊이와 속도를 자유롭게 조정할 수 있다.

AI는 단순한 조수를 넘어, 독립적으로 문제를 분석하고 해결하는 에이전트로 진화하고 있는 것이다.

Qwen3는 이 거대한 변화의 서막을 여는 신호탄이다. 다가올 시대는, AI를 ‘잘 다루는 자’가 아니라, AI의 사고를 ‘잘 설계하는 자’가 주도할 것임을 예고하고 있다.

[저작권자ⓒ META-X. 무단전재-재배포 금지]