안드로이드 XR, ‘일상 속 컴퓨팅’으로 진입하다

[메타X(MetaX)] 구글이 안드로이드 XR 생태계를 본격적으로 확장하며, 혼합현실(XR)을 실험적 기술이 아닌 일상적 컴퓨팅 플랫폼으로 끌어올리고 있다.

구글은 2025년 12월 8일 열린 ‘The Android Show: XR Edition’에서 삼성 갤럭시 XR 헤드셋의 신규 기능을 공개하는 한편, 파트너사들과 함께 준비 중인 차세대 XR 기기들의 방향성을 처음으로 제시했다.

구글은 지난해 12월 안드로이드 XR 비전을 처음 공개한 이후, 지난달 삼성 갤럭시 XR 헤드셋 출시를 통해 이를 현실로 옮기기 시작했다. 이번 행사는 그 다음 단계로, 안드로이드 XR이 단순한 헤드셋 경험을 넘어 업무·이동·커뮤니케이션 전반으로 확장되고 있음을 보여주는 자리였다.

이번에 공개된 갤럭시 XR 업데이트의 핵심은 ‘일상 적합성’이다. 구글은 XR이 진정으로 유용해지기 위해서는 공간 컴퓨팅의 강점을 살리면서도 사용자의 일상 흐름에 자연스럽게 스며들어야 한다고 설명했다. 이를 위해 PC Connect, 여행 모드(Travel Mode), 그리고 리얼리스틱 아바타 기능인 Likeness가 새롭게 추가됐다.

PC Connect는 윈도우 PC를 갤럭시 XR 헤드셋과 연결해, PC 데스크톱이나 특정 창을 XR 공간으로 불러올 수 있도록 하는 기능이다. 사용자는 구글 플레이 기반 네이티브 앱과 PC 화면을 나란히 배치해 작업할 수 있으며, 이는 노트북 화면의 물리적 한계를 넘어서는 확장된 작업 환경을 제공한다. PC 게임 스트리밍도 지원되며, 플레이 중 제미나이(Gemini)를 통해 실시간 게임 팁을 받을 수 있다. PC Connect는 베타 버전으로 순차 배포된다.

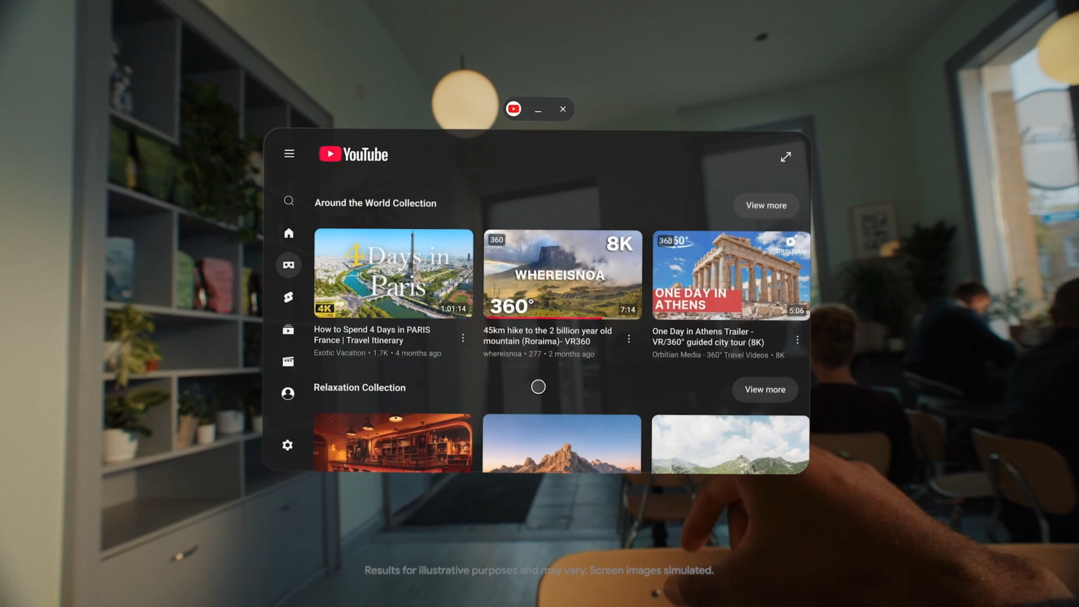

여행 모드는 이동 중 환경을 고려한 기능이다. 비행기와 같은 이동 상황에서도 화면이 흔들리지 않도록 시야를 안정화해, 좁은 좌석에서도 개인 영화관이나 몰입형 업무 공간을 구현할 수 있다. 구글은 이를 통해 XR이 고정된 공간에서만 사용하는 기기가 아니라, 이동 중에도 활용 가능한 컴퓨팅 도구로 진화하고 있음을 강조했다.

커뮤니케이션 영역에서는 Likeness가 핵심 변화로 꼽힌다. Likeness는 사용자의 얼굴 표정과 손 제스처를 실시간으로 반영하는 사실적인 디지털 아바타로, XR 헤드셋 착용 상태에서도 자연스러운 화상회의를 가능하게 한다. 상대방은 헤드셋 뒤에 숨겨진 사용자가 아니라, 실제 표정과 움직임을 반영한 ‘나 자신’을 마주하게 되며, 이는 XR 환경에서의 사회적 거리감을 크게 줄이는 역할을 한다. Likeness 역시 베타로 제공되며, 구글 헬프센터를 통해 설정할 수 있다.

구글은 갤럭시 XR 업데이트와 함께, 안드로이드 XR 생태계의 하드웨어 다변화 전략도 공개했다. 구글은 “하나의 폼팩터가 모든 사용자에게 적합할 수는 없다”며, 무게·스타일·몰입도의 균형이 다른 다양한 XR 기기를 지원하는 것이 목표라고 밝혔다.

그 일환으로 구글은 삼성, 젠틀몬스터, 워비파커와 협력해 ‘AI 글래스’를 개발 중이다. 이 글래스는 하루 종일 착용 가능한 경량 디자인을 목표로 하며, 두 가지 유형으로 나뉜다. 하나는 화면이 없는 AI 글래스로, 카메라·마이크·스피커를 통해 제미나이와 자연스럽게 대화하고 주변 환경에 대한 도움을 받을 수 있다. 다른 하나는 렌즈 내 디스플레이를 탑재한 디스플레이 AI 글래스로, 길 안내나 번역 자막과 같은 정보를 사용자의 시야에 조용히 표시한다. 첫 번째 제품군은 2026년 출시될 예정이다.

또 다른 형태의 기기로는 XREAL과 협력한 유선 XR 글래스 ‘프로젝트 아우라(Project Aura)’가 소개됐다. 이 기기는 70도 시야각과 광학 시스루(optical see-through) 기술을 기반으로, 현실 세계 위에 디지털 콘텐츠를 겹쳐 보여준다. 사용자는 주변 환경을 가리지 않은 채, 여러 개의 가상 창을 띄워 업무나 엔터테인먼트를 즐길 수 있다. 요리 중 레시피 영상을 띄우거나, 가전제품 수리 시 단계별 안내를 시각적으로 확인하는 등 실용적 활용이 강조됐다. 프로젝트 아우라는 내년 정식 공개를 앞두고 있다.

플랫폼 확장을 위해 개발자 지원도 강화된다. 구글은 안드로이드 XR SDK의 Developer Preview 3를 공개하며, AI 글래스 개발을 공식적으로 개방했다. 이를 통해 개발자들은 음성·시각·공간 정보를 결합한 증강 경험을 설계할 수 있으며, 우버(Uber), 겟유어가이드(GetYourGuide)와 같은 파트너 사례가 이미 공유되고 있다. 헤드셋과 유선 XR 글래스를 위한 몰입형 기능 역시 추가됐다.

이번 발표는 안드로이드 XR이 ‘미래 기술 데모’ 단계에서 벗어나, 실제 사용 시나리오를 중심으로 한 생태계 구축 단계에 진입했음을 보여준다. 구글은 XR을 스마트폰 이후의 차세대 컴퓨팅 플랫폼으로 보고 있으며, AI와 결합된 안드로이드 XR은 업무·이동·학습·소통 전반을 아우르는 새로운 인터페이스로 자리 잡을 가능성을 키우고 있다.

XR이 과연 대중의 일상에 안착할 수 있을지에 대한 질문에 대해, 구글은 이번 행사를 통해 하나의 답을 제시했다. “더 가볍게, 더 자연스럽게, 그리고 더 실용적으로.” 안드로이드 XR의 다음 단계는 이미 시작됐다.

[저작권자ⓒ META-X. 무단전재-재배포 금지]