[메타X(MetaX)] Google이 Google Maps에 생성형 AI Gemini를 본격 통합하며 지도 서비스의 역할을 한 단계 끌어올린다. 장소 검색과 추천에 머물렀던 생성형 AI 활용을 내비게이션과 주행 중 음성 인터랙션 영역까지 확장하겠다는 구상이다.

![[메타X(MetaX)]구글 지도, ‘제미나이’ 통합으로 내비게이션·음성 활용까지 확장](https://metax.kr/news/data/2026/01/31/p1065611628907428_805_thum.png)

구글은 2025년 11월 5일(현지시간)부터 구글 지도에 제미나이를 적용해 운전 중 음성 기반 질의응답, 향상된 경로 안내, 핸즈프리 작업 수행 기능을 순차적으로 제공한다고 밝혔다. 이는 2024년 도입된 생성형 AI 기반 장소 탐색 기능을 실제 이동 상황으로 확장한 조치로, 지도가 단순한 검색 도구를 넘어 ‘주행 동반자’로 진화하고 있음을 보여준다.

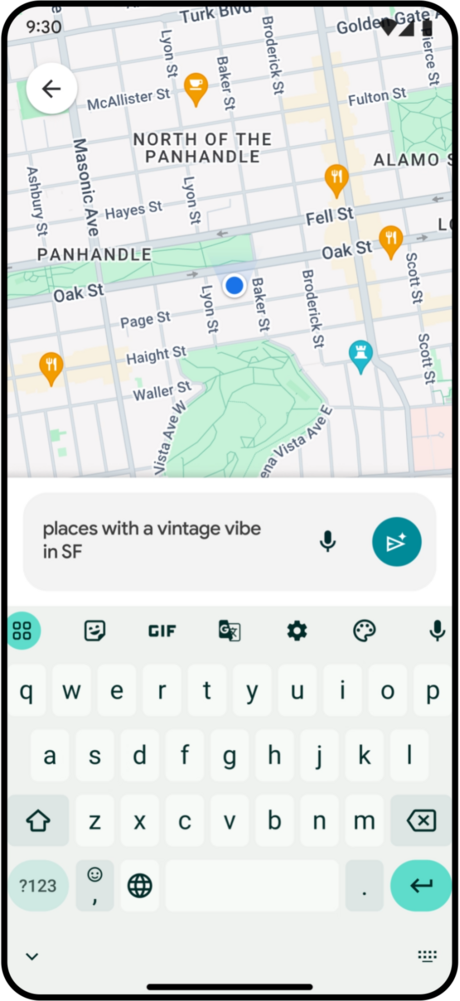

이번 업데이트의 핵심은 운전 중에도 AI와 대화할 수 있는 구조다. 사용자는 주행 중 음성으로 제미나이에 질문해 경로 인근의 식당이나 주차장 정보를 묻거나, 예산·채식 여부 등 여러 조건을 결합한 연속 질문을 이어갈 수 있다. 예를 들어 “경로 근처에 저렴한 비건 식당이 있는지”를 묻고 이어서 “주차는 가능한지”를 질문하면, 제미나이는 이를 하나의 대화 흐름으로 이해해 답변한다. 장소 정보 외에도 스포츠 결과나 뉴스 요약 같은 일반 정보 질의가 가능하며, 일정 추가와 같은 간단한 작업도 음성으로 처리할 수 있다.

![[메타X(MetaX)]구글 지도, ‘제미나이’ 통합으로 내비게이션·음성 활용까지 확장](https://metax.kr/news/data/2026/01/31/p1065611628907428_277_thum.png)

구글은 내비게이션 안내 방식도 함께 바꾼다. 기존의 거리 중심 안내 대신, 스트리트 뷰 데이터와 제미나이를 결합해 눈에 잘 띄는 랜드마크를 기준으로 길을 설명하는 방식이다. “500미터 후 우회전”이 아니라 “주유소를 지난 뒤 우회전”처럼 실제 주행 환경에서 직관적으로 인식할 수 있는 안내가 제공된다. 이를 위해 제미나이는 지도에 등록된 2억5천만 개 장소 정보와 스트리트 뷰 이미지를 교차 분석해, 도로 위에서 식별 가능한 건물과 시설을 기준점으로 활용한다.

보행자와 관광객을 겨냥한 기능도 추가된다. 구글 지도는 Google Lens와 제미나이를 연동해, 사용자가 카메라로 주변 건물이나 음식점을 비춘 뒤 “이곳은 무엇이고 왜 유명한가”와 같은 질문을 할 수 있도록 했다. 이는 낯선 지역에서 주변 정보를 즉시 파악하려는 수요를 겨냥한 기능으로, 지도와 카메라, 생성형 AI를 하나의 경험으로 묶는다.

출시는 단계적으로 이뤄진다. 교통 알림과 일부 음성 기능은 미국 내 안드로이드 사용자부터 적용되며, 랜드마크 기반 내비게이션은 미국 내 iOS와 안드로이드에서 우선 제공된다. 렌즈와 제미나이 연동 기능 역시 미국에서 먼저 선보인 뒤 확대될 예정이다. 구글은 안드로이드 오토(Android Auto) 지원도 예고했다.

이번 통합은 구글 지도의 방향성을 분명히 보여준다. 검색어를 입력해 결과를 고르는 지도에서, 이동 중 상황을 이해하고 판단을 보조하는 AI 플랫폼으로의 전환이다. 구글은 “지도는 단순한 길 안내를 넘어 사용자의 이동 전반을 이해하고 돕는 AI 기반 서비스로 발전하고 있다”고 설명했다. 생성형 AI가 지도에 깊숙이 결합되면서, 길 찾기는 점점 ‘질문하고 대화하는 경험’으로 바뀌고 있다.

[저작권자ⓒ META-X. 무단전재-재배포 금지]