고희소성 MoE, 하드웨어 양자화 혁신을 통한 AI 효율성 및 안전성 확보

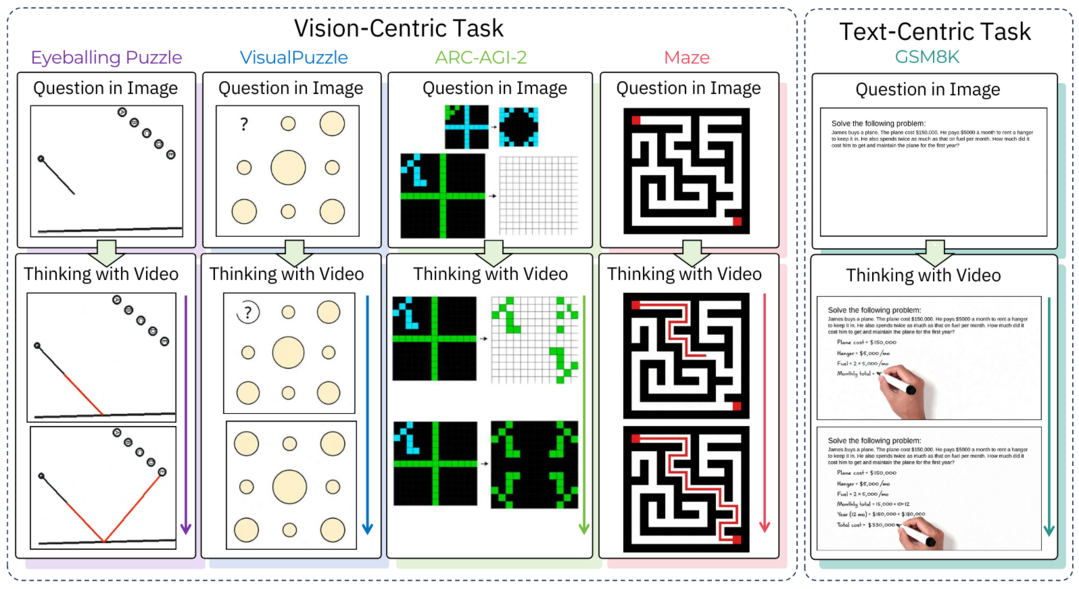

Thinking with Video: Video Generation as a Promising Multimodal Reasoning Paradigm

https://arxiv.org/abs/2511.04570

'Thinking with Video'는 텍스트와 이미지 기반 추론의 정적인 한계를 극복하기 위해 Sora-2와 같은 비디오 생성 모델을 활용하는 새로운 패러다임을 제안한다. 이 접근법은 동적인 프로세스와 연속적인 변화를 통일된 시간적 프레임워크 안에서 통합적으로 다루며, 이를 검증하기 위해 VideoThinkBench라는 벤치마크를 개발했다. 이 벤치마크에서 Sora-2는 비전 및 텍스트 중심 작업 모두에서 강력한 추론 능력을 입증하며, 비디오 생성 모델이 텍스트와 비전을 아우르는 통합 멀티모달 추론기로서의 잠재력을 지니고 있음을 보여준다.

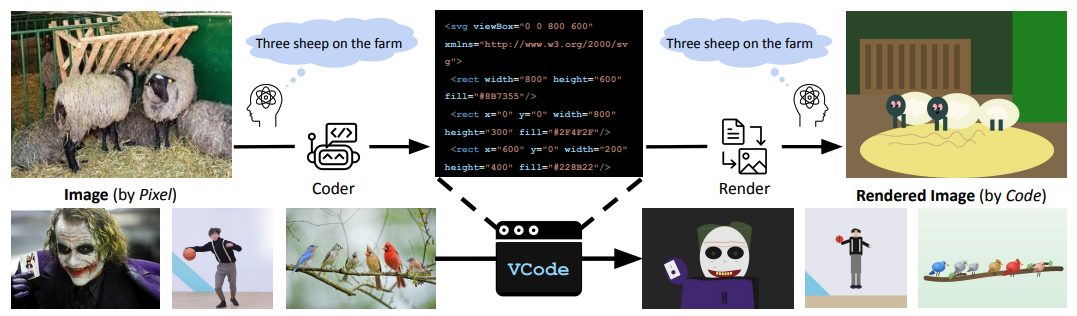

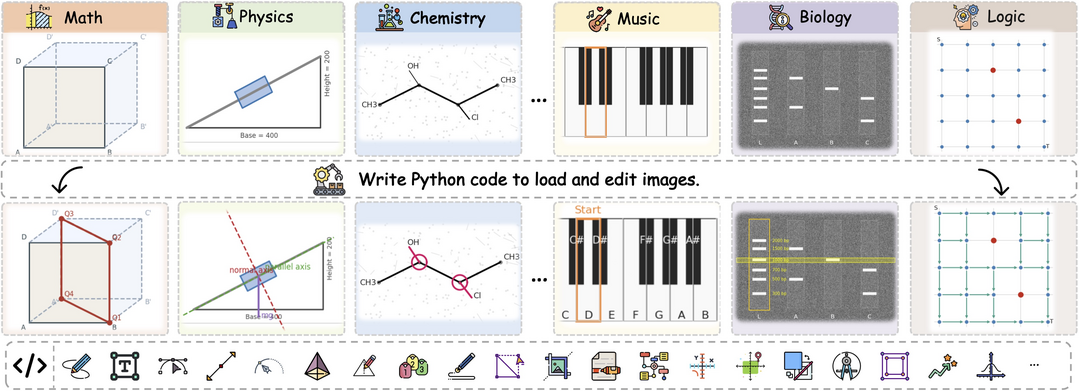

VCode: a Multimodal Coding Benchmark with SVG as Symbolic Visual Representation

https://arxiv.org/abs/2511.02778

VCode는 기존 AI 연구가 소홀히 다룬 '시각 중심 코딩' 문제를 해결하기 위해, 이미지를 해석 가능하고 실행 가능한 SVG 코드로 변환하는 새로운 벤치마크를 제시한다. 이 논문은 생성된 SVG가 원본의 상징적 의미를 얼마나 잘 보존하는지 평가하는 CodeVQA 프로토콜을 함께 제안하며, 기존 VLM의 SVG 생성 한계를 극복하기 위해 반복적인 '수정(Revision)'과 '시각적 도구(Visual Tools)'를 활용하는 에이전트 프레임워크 VCoder를 개발해 우수한 성능을 달성한다.

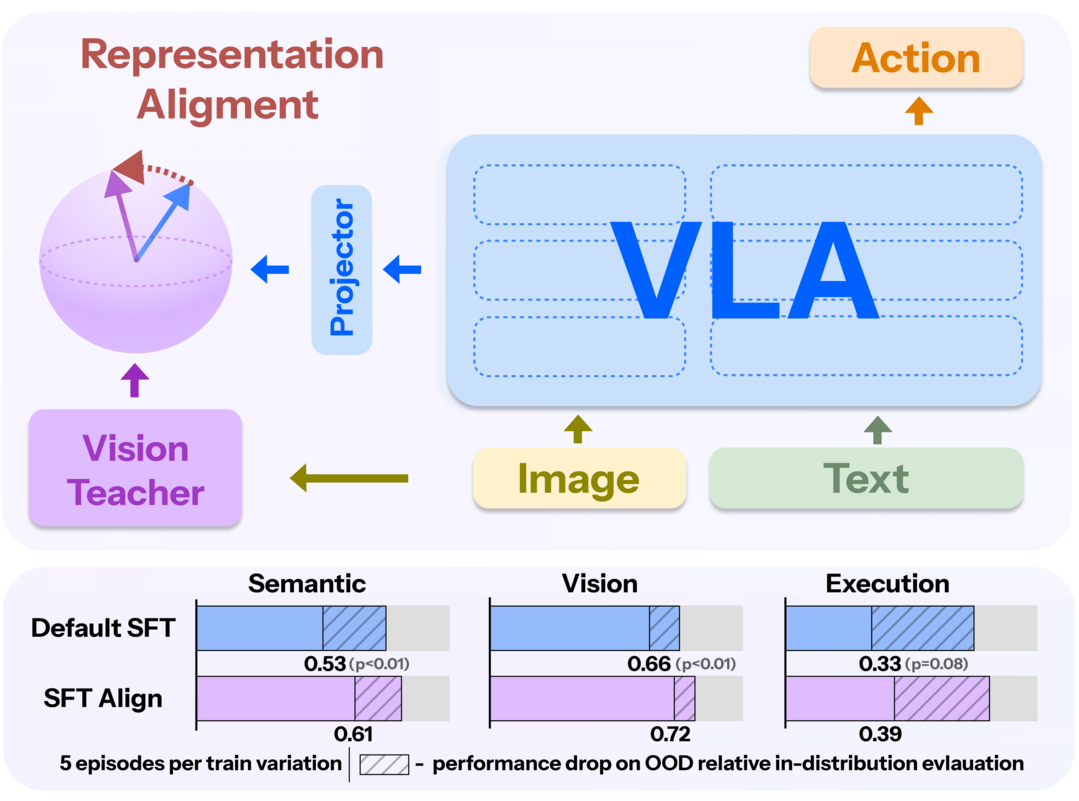

Don't Blind Your VLA: Aligning Visual Representations for OOD Generalization

https://arxiv.org/abs/2510.25616

'Don't Blind Your VLA'는 VLM(시각-언어 모델)을 행동(Action) 데이터로 미세 조정해 VLA(시각-언어-행동) 모델을 만들 때, VLM이 원래 가지고 있던 강력한 시각-언어 표현력이 저하되는 문제를 체계적으로 규명한다. 이러한 표현력 저하는 특히 학습되지 않은 새로운 환경(OOD)에서의 일반화 성능을 심각하게 떨어뜨리며, 이 연구는 내부 표현 분석을 통해 이를 입증하고 행동 학습 중에도 기존 VLM의 지식을 보존하도록 시각적 표현을 정렬하는 효과적인 완화 전략을 제안한다.

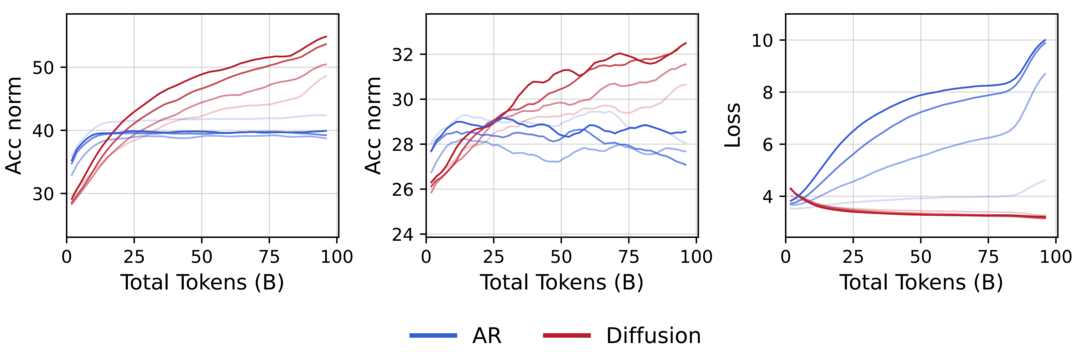

Diffusion Language Models are Super Data Learners

https://arxiv.org/abs/2511.03276

'Diffusion Language Models are Super Data Learners'는 확산(Diffusion) 언어 모델(DLM)이 자기회귀(AR) 모델보다 데이터 학습 효율이 뛰어남을 입증한다. 이 연구는 고유한 데이터가 제한된 환경에서 데이터를 반복 학습시킬 경우, DLM이 AR 모델의 성능을 일관되게 능가하는 '교차(Crossover)' 현상을 발견했으며, 이는 DLM의 순서 무관(any-order) 모델링과 고밀도 연산 특성 덕분이라고 분석한다. 결론적으로 DLM은 제한된 데이터를 '짜내어' 학습하는 데 매우 강력한 '슈퍼 데이터 학습자'임을 시사한다.

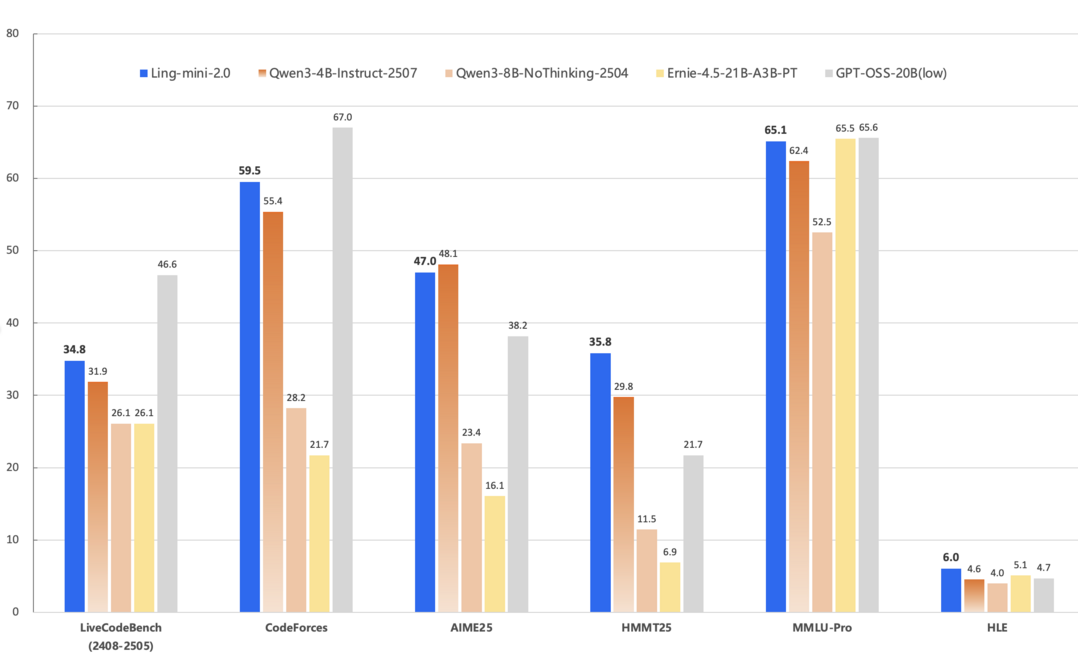

Every Activation Boosted: Scaling General Reasoner to 1 Trillion Open Language Foundation

https://arxiv.org/abs/2510.22115

'Every Activation Boosted'는 '모든 활성화가 추론 능력을 증폭시킨다'는 원칙에 기반하여 160억 개부터 1조 개 파라미터까지 확장되는 추론 지향 언어 모델 시리즈 Ling 2.0을 제안한다. 이 모델은 고희소성 MoE 아키텍처를 채택하여 기존 덴스 모델 대비 압도적인 연산 효율을 달성했으며, 추론 지향 데이터(CoT) 학습과 강화 학습 기반 미세 조정, FP8 인프라 등 혁신을 통합했다. 그 결과, 1조 파라미터 모델인 Ling-1T는 추론 정확도와 계산 효율성 측면에서 새로운 파레토 프론티어를 확립한다.

ThinkMorph: Emergent Properties in Multimodal Interleaved Chain-of-Thought Reasoning

https://arxiv.org/abs/2510.27492

'ThinkMorph'는 진정한 멀티모달 추론이란 텍스트와 이미지가 중복되는 것이 아니라, 추론을 함께 발전시키는 '상호 보완적' 관계여야 한다고 주장한다. 이 원칙에 따라 개발된 ThinkMorph 모델은 24,000개의 고품질 인터리브드(interleaved) 추론 데이터로 학습했으며, 언어적 논리를 유지하면서 시각적 콘텐츠를 구체적으로 '조작'하는 텍스트-이미지 사고 단계를 생성한다. 그 결과, 비전 중심 벤치마크에서 베이스 모델 대비 평균 34.7%의 큰 성능 향상을 보였을 뿐만 아니라, 학습하지 않은 시각 조작 기술을 선보이는 '창발적(emergent)' 특성을 드러낸다.

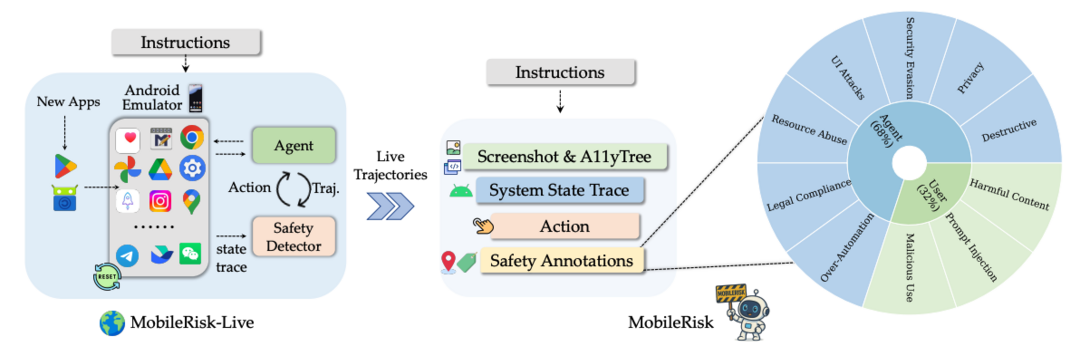

OS-Sentinel: Towards Safety-Enhanced Mobile GUI Agents via Hybrid Validation in Realistic Workflows

https://arxiv.org/abs/2510.24411

'OS-Sentinel'은 VLM 기반 모바일 GUI 에이전트가 시스템을 손상시키거나 개인 정보를 유출하는 등의 '안전하지 않은 작동'을 탐지하기 위한 하이브리드 프레임워크를 제안한다. 이 연구는 실제적인 위협 시나리오를 포함하는 샌드박스 환경 'MobileRisk-Live'를 구축했으며, OS-Sentinel은 명시적인 시스템 규칙 위반을 탐지하는 '정형 검증기'와 문맥적 위험을 판단하는 'VLM 기반 문맥 판단기'를 결합한다. 이 하이브리드 접근법은 기존 탐지 방식보다 10~30% 향상된 정확도로 더 안전한 모바일 에이전트 개발의 기반을 마련한다.

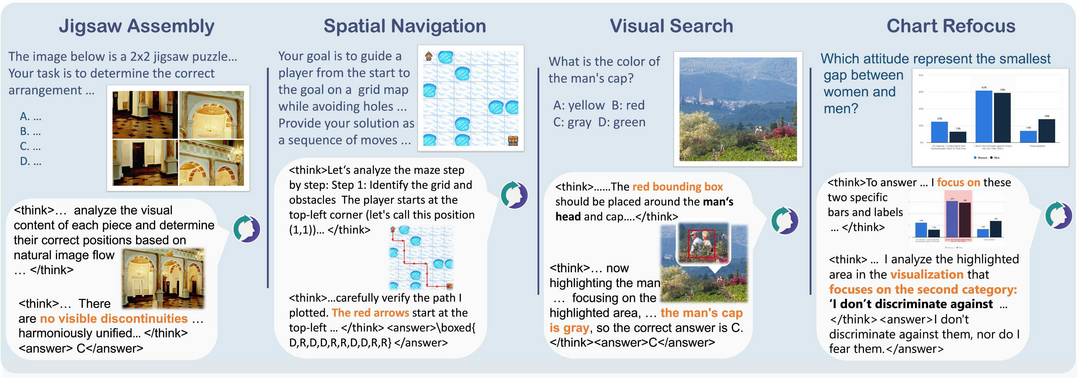

V-Thinker: Interactive Thinking with Images

https://arxiv.org/abs/2511.04460

'V-Thinker'는 LMM(대형 멀티모달 모델)이 이미지와 깊게 '상호작용'하며 장기적 추론을 수행하도록 설계된 범용 추론 보조 모델이다. 이 모델은 '데이터 진화 플라이휠'을 통해 고품질의 상호작용 추론 데이터셋을 자동으로 생성 및 검증하며, '시각적 점진적 학습 커리큘럼'이라는 2단계 강화 학습 프레임워크를 통해 상호작용 능력을 학습한다. V-Thinker는 새롭게 도입된 VTBench 벤치마크에서 기존 LMM 기반 모델들을 일관되게 능가하며, 이미지 상호작용 추론의 새로운 가능성을 제시한다.

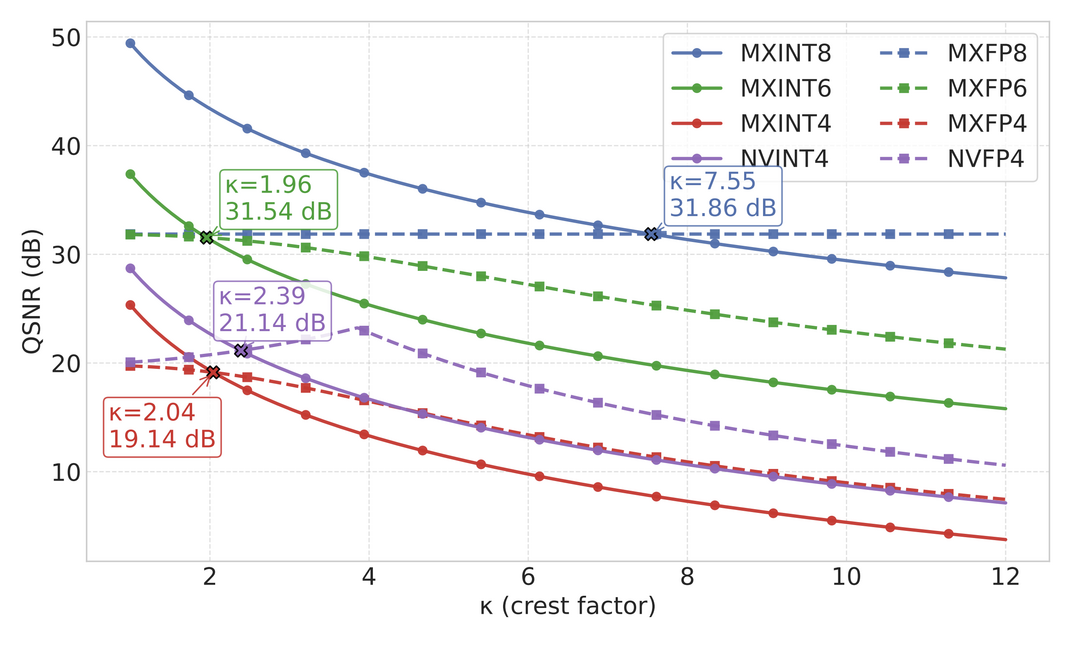

INT v.s. FP: A Comprehensive Study of Fine-Grained Low-bit Quantization Formats

https://arxiv.org/abs/2510.25602

'INT v.s. FP'는 최신 AI 하드웨어가 저정밀 부동 소수점(FP) 형식을 선호하는 추세 속에서, 저정밀 정수(INT)와 FP 형식의 성능을 세분화된(fine-grained) 수준에서 체계적으로 비교 분석한다. 이 연구는 8비트 수준에서는 세분화된 정수 형식인 MXINT8이 FP보다 알고리즘 정확도와 하드웨어 효율성 모두에서 우수하다는 '성능 교차(crossover)'를 밝혀냈다. 4비트에서는 FP가 종종 우세하지만, 이는 하드웨어 설계가 FP 일변도로 가는 것이 최적이 아닐 수 있으며, MXINT8과 같은 세분화된 INT 형식이 더 나은 균형점을 제공할 수 있음을 시사한다.

World Simulation with Video Foundation Models for Physical AI

https://arxiv.org/abs/2511.00062

'World Simulation with Video Foundation Models for Physical AI'는 Physical AI 연구를 위한 차세대 월드 파운데이션 모델 [Cosmos-Predict2.5]를 소개한다. 이 모델은 Flow 기반 아키텍처를 통해 텍스트, 이미지, 비디오로부터 일관된 월드 시뮬레이션 생성을 단일 모델로 통합했으며, 2억 개의 비디오 데이터와 강화 학습으로 정제되어 비디오 품질과 명령어 정렬 능력이 크게 향상되었다. 또한, Sim2Real 변환을 위한 [Cosmos-Transfer2.5]와 함께 공개되어 로보틱스 및 자율 시스템을 위한 합성 데이터 생성과 정책 평가를 가속화한다.

[METAX = 김한얼 기자]

[저작권자ⓒ META-X. 무단전재-재배포 금지]