작은 모델의 추론 혁명, 메모리 환각 평가, 안전 얼라인먼트의 창의적 한계

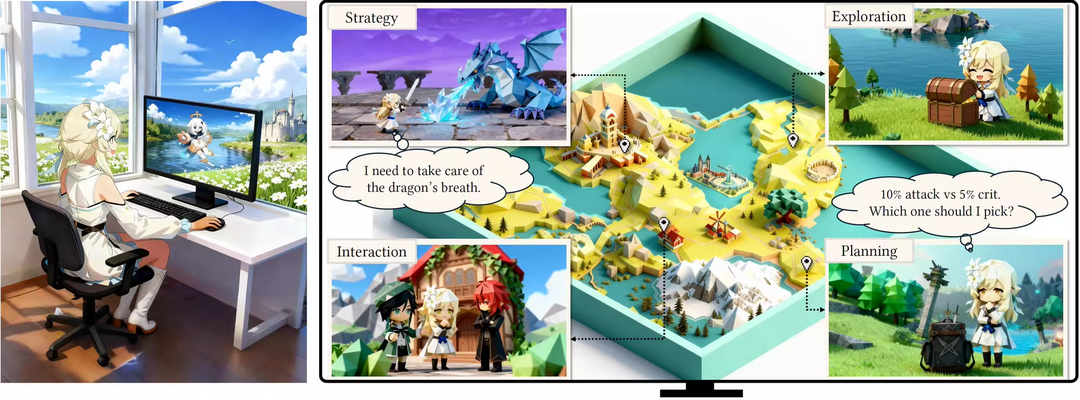

Lumine: An Open Recipe for Building Generalist Agents in 3D Open Worlds

https://arxiv.org/abs/2511.08892

[메타X(MetaX)] 'Lumine'은 3D 오픈월드 환경에서 실시간으로 장시간의 복잡한 임무를 완수할 수 있는 범용 에이전트 개발을 위한 최초의 오픈 레시피를 제시한다. 이 에이전트는 비전-언어 모델(VLM)을 기반으로 인식, 추론, 행동을 엔드-투-엔드 방식으로 통합하며, 5Hz의 원시 픽셀 입력을 30Hz의 정밀한 키보드/마우스 조작으로 변환하고 필요시 적응형으로 추론을 수행한다. '원신'에서 훈련된 Lumine은 5시간 분량의 메인 스토리를 인간 수준의 효율로 완료하고 자연어 지시를 따라 다양한 작업을 수행하며, 특히 별도 학습 없이 '명조'나 '붕괴: 스타레일' 같은 타 게임에서도 뛰어난 제로샷 일반화 성능을 입증했다.

Grounding Computer Use Agents on Human Demonstrations

https://arxiv.org/abs/2511.07332

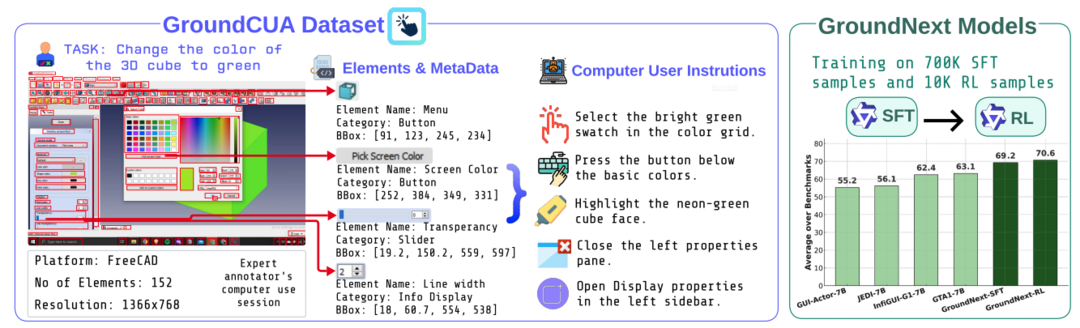

컴퓨터 제어 에이전트가 자연어 지시를 화면 UI 요소와 정확히 연결하는 '그라운딩'은 필수적이지만, 데스크톱 환경을 위한 고품질 데이터셋은 부족했다. 이 연구는 이러한 문제를 해결하기 위해 전문가 시연을 기반으로 구축된 대규모 데스크톱 그라운딩 데이터셋 'GroundCUA'를 소개한다. GroundCUA는 87개 애플리케이션과 356만 개 이상의 검증된 주석을 포함하며, 이를 기반으로 개발된 'GroundNext' 모델은 기존보다 10분의 1 미만의 데이터로도 5개 벤치마크에서 SOTA 성능을 달성했다. 이는 고품질 전문가 데이터셋이 범용 컴퓨터 에이전트 발전에 결정적인 역할을 함을 보여준다.

Tiny Model, Big Logic: Diversity-Driven Optimization Elicits Large-Model Reasoning Ability in VibeThinker-1.5B

https://arxiv.org/abs/2511.06221

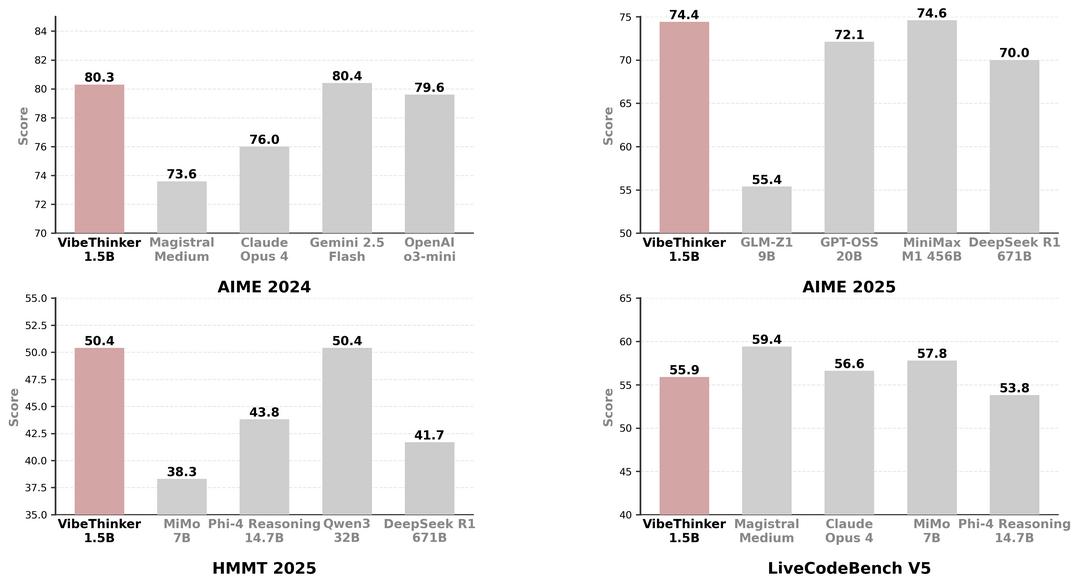

'VibeThinker-1.5B' 연구는 작은 모델이 강력한 추론 능력을 갖기 어렵다는 통념에 도전하며, 15억 파라미터의 상대적으로 작은 모델로도 대형 모델 수준의 추론이 가능함을 입증했다. 연구팀은 'SSP'라는 자체 훈련 프레임워크를 적용하고 단 7,800달러의 비용으로 모델을 훈련시켰다. 그 결과, VibeThinker-1.5B는 여러 수학 벤치마크에서 400배 더 큰 DeepSeek R1 모델을 능가하고 주요 코딩 벤치마크에서도 우수한 성능을 기록하며, 적은 비용으로도 고급 AI 추론 능력을 달성할 수 있음을 시사한다.

HaluMem: Evaluating Hallucinations in Memory Systems of Agents

https://arxiv.org/abs/2511.03506

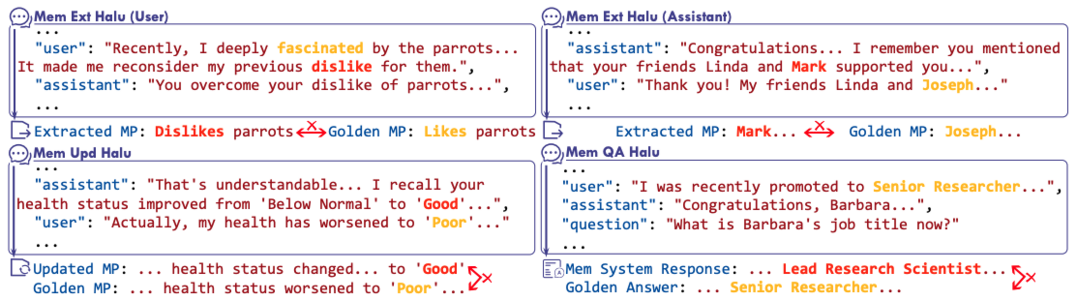

'HaluMem'은 AI 에이전트의 메모리 시스템에서 발생하는 환각 현상을 평가하기 위한 최초의 '작동 단계별' 벤치마크를 제시한다. 기존 평가 방식이 최종 결과물에만 초점을 맞춘 것과 달리, HaluMem은 '메모리 추출', '메모리 업데이트', '메모리 질의응답'의 세 단계로 나누어 환각 발생 지점을 정밀하게 진단한다. 연구 결과, 환각은 단순히 응답 단계에서 발생하는 것이 아니라, 정보를 추출하고 업데이트하는 초기 단계에서부터 발생 및 누적되어 후속 단계로 전파되는 것으로 밝혀졌다. 이는 메모리 시스템의 신뢰성을 높이기 위한 근본적인 연구가 필요함을 보여준다.

IterResearch: Rethinking Long-Horizon Agents via Markovian State Reconstruction

https://arxiv.org/abs/2511.07327

'IterResearch'는 장기 탐색(long-horizon) 리서치 에이전트가 단일 컨텍스트 창에 정보를 누적하며 발생하는 성능 저하 문제를 해결하기 위해 새로운 '반복적' 패러다임을 제안한다. 이 방식은 탐색 과정을 마르코프 결정 과정으로 재정의하고, 모든 정보를 쌓는 대신 '진화하는 리포트'를 메모리로 유지하며 주기적으로 통찰을 합성해 컨텍스트를 재구성한다. 그 결과, IterResearch는 탐색 깊이가 증가해도 일관된 추론 능력을 유지하며, 2048번에 달하는 긴 상호작용에서도 극적인 성능 향상을 보이며 기존 에이전트들을 크게 능가했다.

TiDAR: Think in Diffusion, Talk in Autoregression

https://arxiv.org/abs/2511.08923

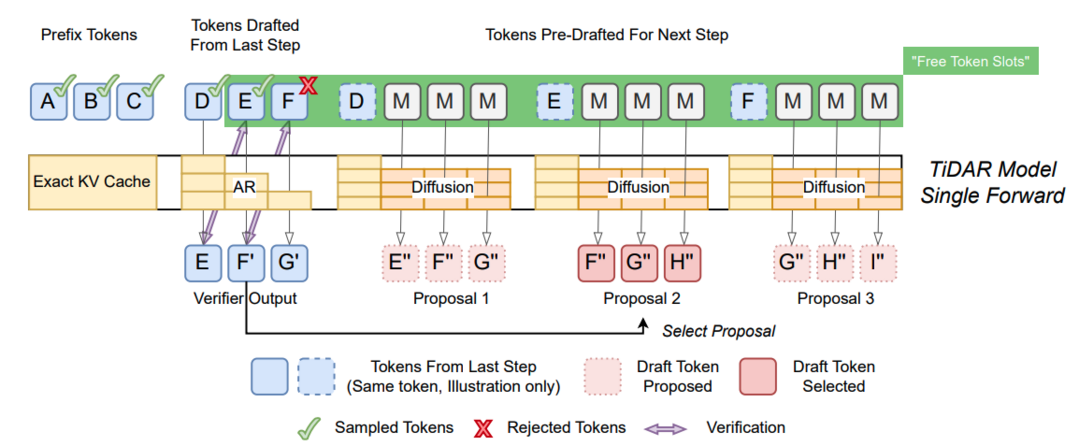

'TiDAR'는 디퓨전 모델의 빠른 병렬 생성 속도와 자기회귀(AR) 모델의 높은 품질이라는 장점을 결합한 새로운 하이브리드 언어 모델 아키텍처다. "디퓨전으로 생각하고(Thinking), 자기회귀로 말한다(Talking)"는 개념에 따라, LiDAR는 단일 순전파(forward pass) 내에서 디퓨전 방식으로 토큰 초안을 병렬로 빠르게 생성한 후, 자기회귀 방식으로 최종 결과물을 샘플링한다. 이 설계 덕분에 LiDAR는 기존 AR 모델과의 품질 격차를 완전히 해소하는 동시에, 초당 토큰 생성 처리량은 4.7배에서 5.9배까지 획기적으로 향상시켰다.

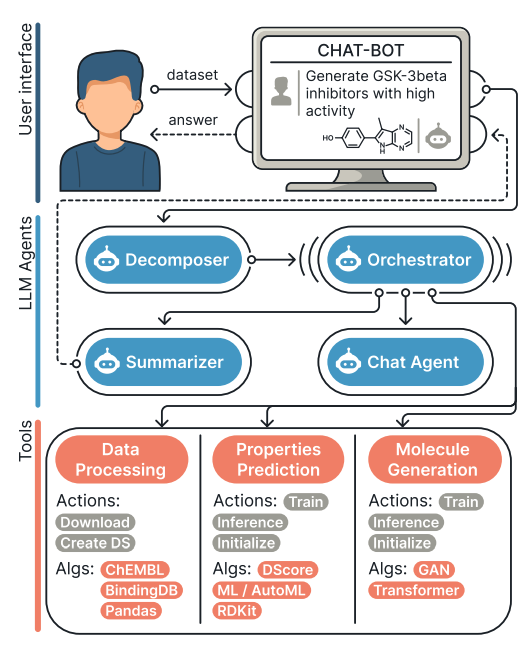

MADD: Multi-Agent Drug Discovery Orchestra

https://arxiv.org/abs/2511.08217

'MADD'는 초기 신약 개발의 핵심 과제인 히트 화합물 발굴을 위한 멀티 에이전트 시스템으로, 복잡한 AI 도구에 대한 실험실 연구자들의 접근성 문제를 해결한다. 사용자가 자연어로 쿼리를 입력하면, MADD는 화합물 생성 및 스크리닝 등 핵심 하위 작업을 처리하는 4개의 전문 에이전트가 오케스트라처럼 협력하여 맞춤형 발굴 파이프라인을 자동으로 구축하고 실행한다. 7개의 실제 신약 발굴 사례 평가에서 MADD는 기존 LLM 솔루션보다 뛰어난 성능을 보였으며, 5개의 새로운 생물학적 표적에 대한 히트 분자를 성공적으로 발굴해냈다.

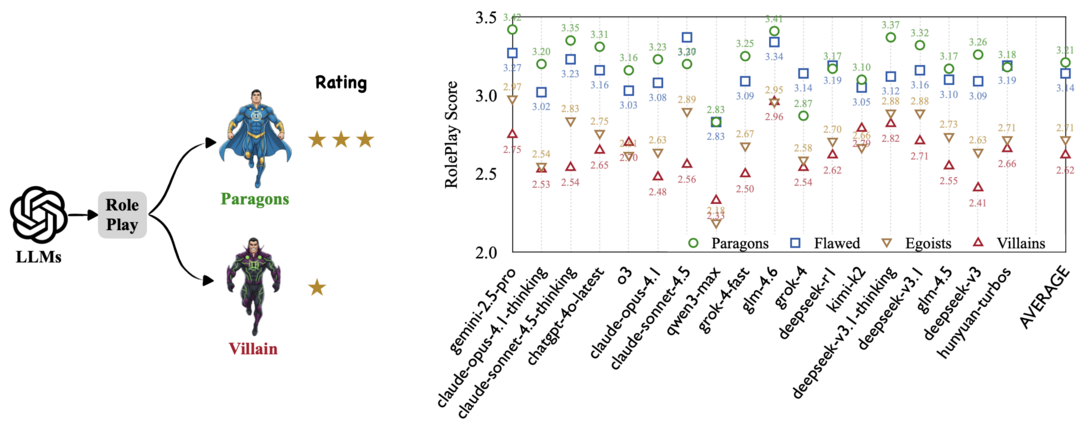

Too Good to be Bad: On the Failure of LLMs to Role-Play Villains

https://arxiv.org/abs/2511.04962

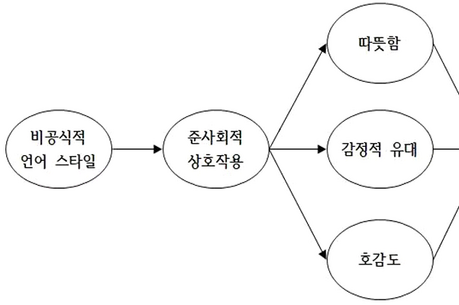

'Too Good to be Bad' 연구는 대형 언어 모델(LLM)이 비사회적이거나 적대적인 '악당' 캐릭터를 연기하는 데 실패하는 현상을 체계적으로 분석했다. 이 논문은 현대 LLM의 강력한 '안전 얼라인먼트'가 도덕적으로 모호한 페르소나를 진정성 있게 구현하는 작업과 근본적으로 충돌한다는 가설을 제시한다. 'Moral RolePlay' 벤치마크를 통한 실험 결과, 모델들은 캐릭터의 도덕성이 낮아질수록 연기 충실도가 일관되게 하락했으며, 특히 '기만'이나 '조종' 같은 특성을 피상적인 공격성으로 대체하는 경향을 보였다. 이는 모델의 안전성과 창의적 충실도 간의 긴장 관계를 보여주는 첫 번째 체계적 증거다.

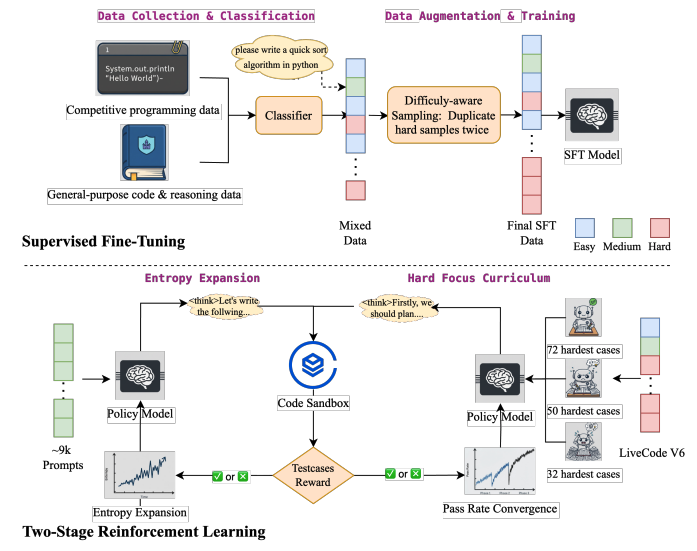

DRIVE: Data Curation Best Practices for Reinforcement Learning with Verifiable Reward in Competitive Code Generation

https://arxiv.org/abs/2511.06307

'DRIVE'는 경쟁 프로그래밍 코드 생성을 위한 RLVR(검증 가능한 보상을 통한 강화학습) 데이터 구축 및 훈련 모범 사례를 제시한다. 이 파이프라인은 SFT(지도 미세조정) 이후 2단계 강화학습 프로세스를 따르는데, 첫 번째 단계에서는 크고 균일한 문제셋으로 엔트로피를 확장하여 반복을 줄이고, 두 번째 단계(Pre-GRPO)에서는 작지만 어려운 고품질 문제셋에 집중하는 '하드-포커스 커리큘럼'을 적용한다. 이 방식을 Qwen2.5-32B 모델에 적용한 결과, LeetCode 및 Codeforces에서 데이터 유출 없이도 DeepSeek v3.1과 같은 최고 수준의 시스템과 동등한 성능을 달성했다.

[METAX = 김한얼 기자]

[저작권자ⓒ META-X. 무단전재-재배포 금지]