자율 데이터 과학, 옴니모달, 훈련 없는 3D 편집 및 새로운 평가 벤치마크

A Theoretical Study on Bridging Internal Probability and Self-Consistency for LLM Reasoning

https://arxiv.org/abs/2510.15444

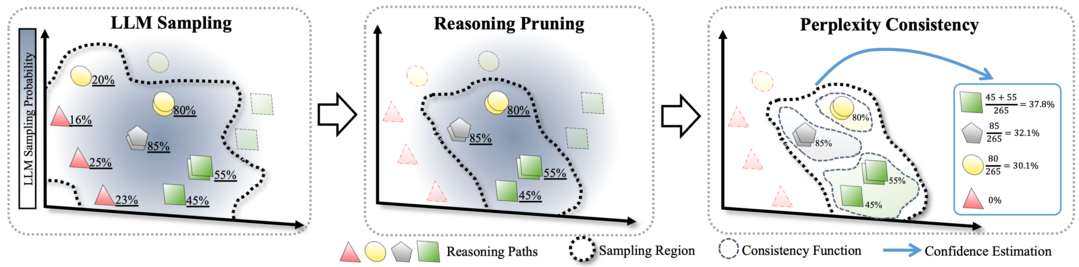

이 논문은 LLM 추론 성능을 높이는 샘플링 기반 테스트 시간 스케일링 방법의 이론적 토대를 최초로 제시한다. 기존의 Self-Consistency는 추정 오류가 높고 Perplexity는 모델링 오류가 크다는 한계를 이론적으로 분석하며, 이 두 방법의 장점을 결합한 RPC(Reasoning Pruning and Perplexity Consistency)라는 새로운 하이브리드 방법을 제안한다. RPC는 낮은 확률의 추론 경로를 제거하고 수렴 속도를 높여, 기존 Self-Consistency와 비슷한 성능을 달성하면서도 샘플링 비용을 50% 절감하고 신뢰도를 향상시킨다.

LightMem: Lightweight and Efficient Memory-Augmented Generation

https://arxiv.org/abs/2510.18866

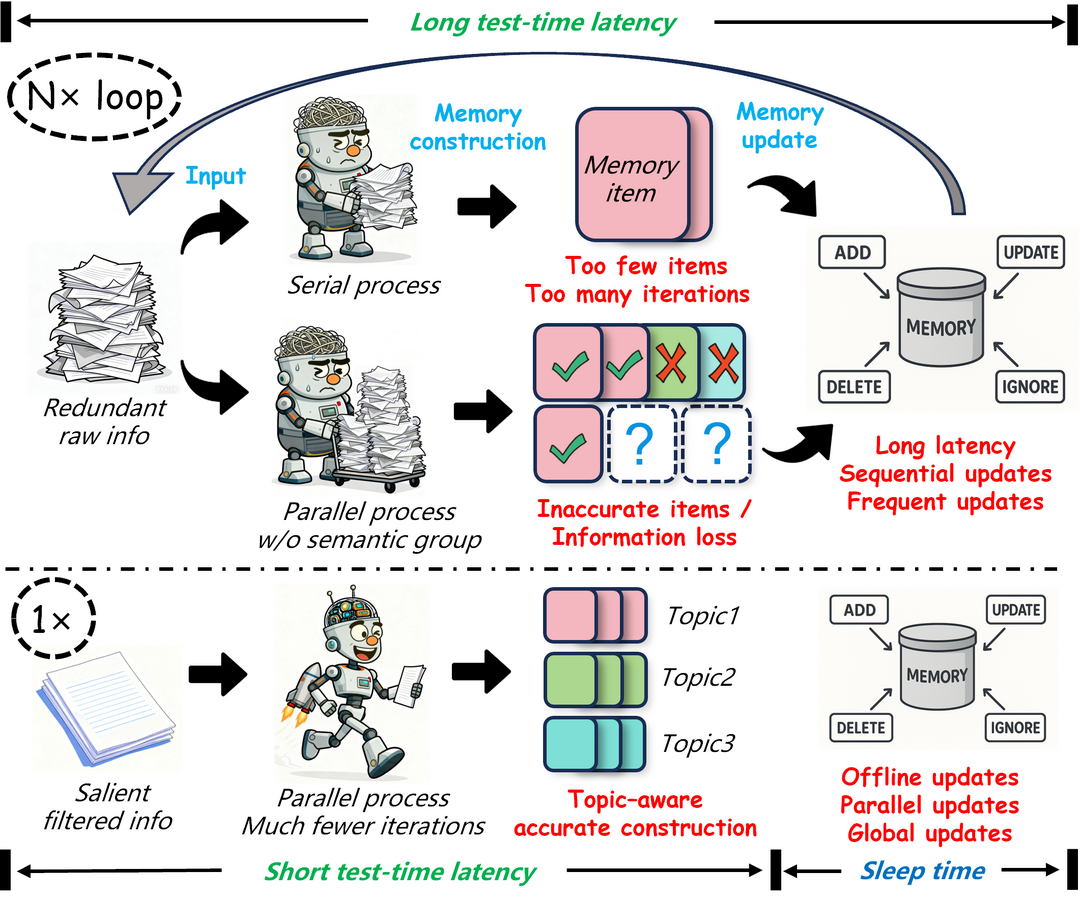

이 논문은 LLM이 과거 상호작용 정보를 효율적으로 활용하도록 돕는 경량 메모리 시스템 LightMem을 제안한다. 인간의 기억 모델(감각-단기-장기)에 착안한 3단계 메모리 구조를 특징으로 하며, 특히 '수면 시간 업데이트' 방식을 도입해 온라인 추론과 메모리 통합 과정을 분리함으로써 기존 메모리 시스템의 높은 시간 및 계산 오버헤드 문제를 해결한다. LightMem은 실험에서 높은 정확도 향상과 더불어 토큰 사용량, API 호출, 런타임을 최대 100배 이상 획기적으로 절감시킨다.

Efficient Long-context Language Model Training by Core Attention Disaggregation

https://www.arxiv.org/abs/2510.18121

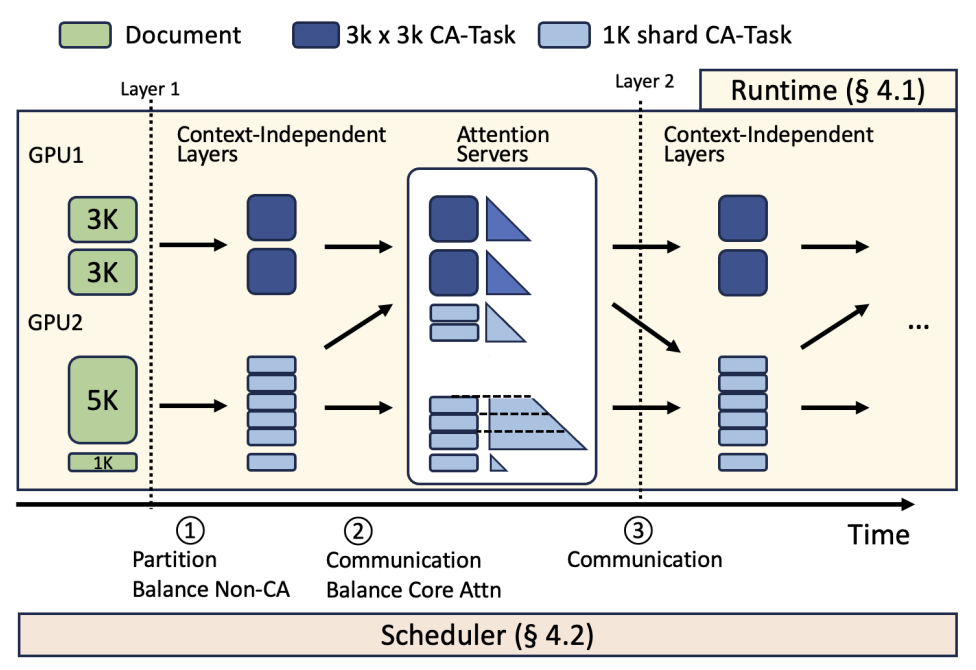

이 논문은 긴 컨텍스트 LLM 훈련 시, 계산량이 2차(quadratic)로 증가하는 '핵심 어텐션'($softmax(QK^T)V$) 연산이 로드 불균형과 지연(straggler)을 유발하는 문제를 해결하는 CAD(Core Attention Disaggregation) 기술을 제시한다. CAD는 훈련 가능한 파라미터가 없는 핵심 어텐션 계산을 나머지 모델 계층과 분리하여 별도의 '전용 어텐션 서버' 풀에서 실행하는 방식이다. 이를 구현한 DistCA 시스템은 어텐션 작업을 토큰 레벨로 분할하고 동적으로 재배치하여 완벽한 로드 밸런싱을 달성하며, 최대 512k 토큰 길이에서 훈련 처리량을 1.35배까지 향상시킨다.

Every Attention Matters: An Efficient Hybrid Architecture for Long-Context Reasoning

https://arxiv.org/abs/2510.19338

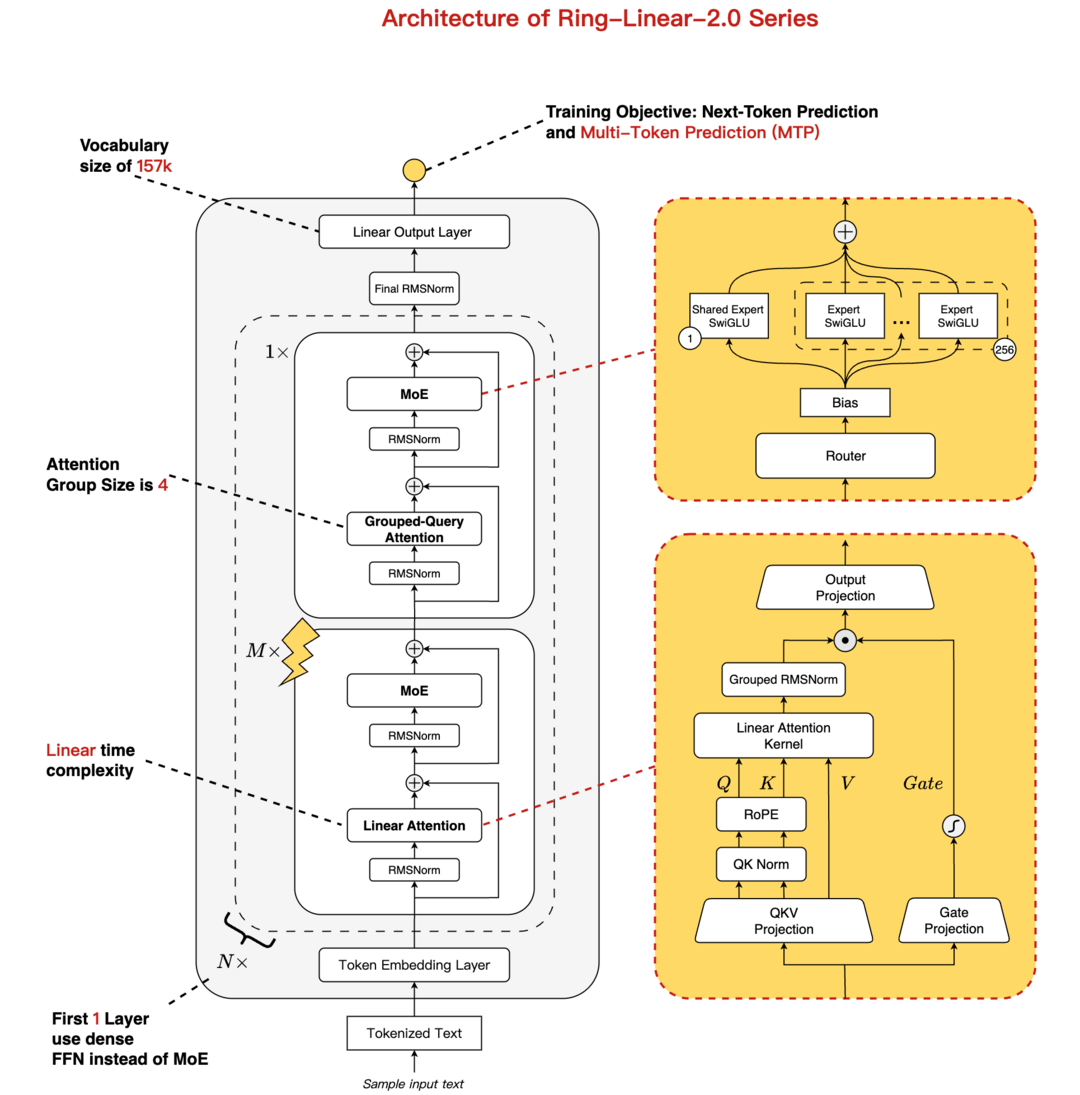

이 논문은 긴 컨텍스트 추론 시 발생하는 I/O 및 계산 오버헤드를 획기적으로 줄이는 Ring-linear 모델 시리즈를 소개한다. 이 모델들은 선형 어텐션(Linear Attention)과 소프트맥스 어텐션(Softmax Attention)을 효과적으로 통합한 하이브리드 아키텍처를 채택하여, 밀집(dense) 모델 대비 추론 비용을 1/10 수준으로 절감한다. 또한 자체 개발한 고성능 FP8 연산자 라이브러리 'linghe'를 활용해 훈련 효율을 50% 향상시켰으며, 이 아키텍처를 통해 복잡한 추론 벤치마크에서 SOTA 성능을 달성한다.

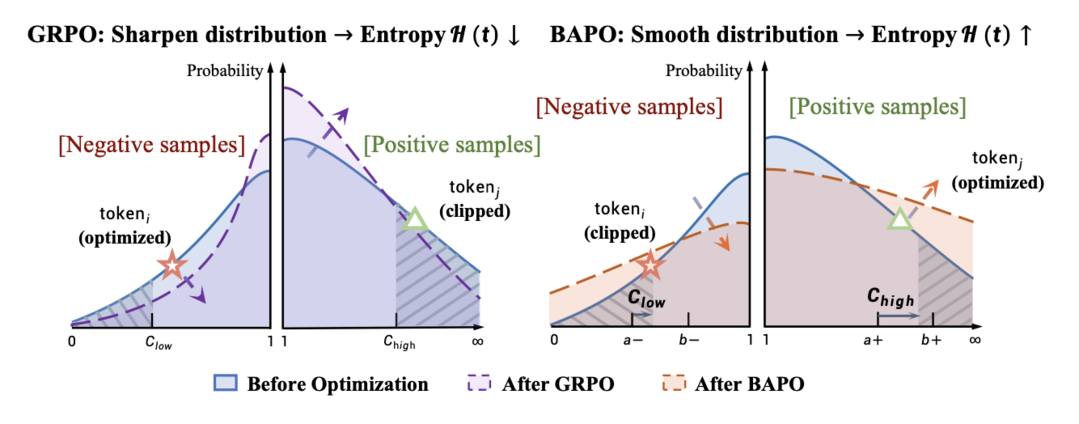

BAPO: Stabilizing Off-Policy Reinforcement Learning for LLMs via Balanced Policy Optimization with Adaptive Clipping

https://arxiv.org/abs/2510.18927

이 논문은 LLM을 오프-폴리시(off-policy) 강화학습으로 훈련할 때 발생하는 불안정성 문제를 해결하는 BAPO 알고리즘을 제안한다. 기존 방식은 '음의 이점(negative-advantage)' 샘플이 최적화를 지배하는 불균형과 고정된 클리핑 메커니즘이 엔트로피 증가를 막는 문제로 인해 훈련이 붕괴될 수 있음을 밝혀낸다. BAPO는 클리핑 경계를 동적으로 조정하는 '적응형 클리핑'을 도입하여 긍정적 기여와 부정적 기여의 균형을 맞추고 엔트로피를 보존함으로써, 빠르고 안정적인 데이터 효율적 훈련을 달성한다.

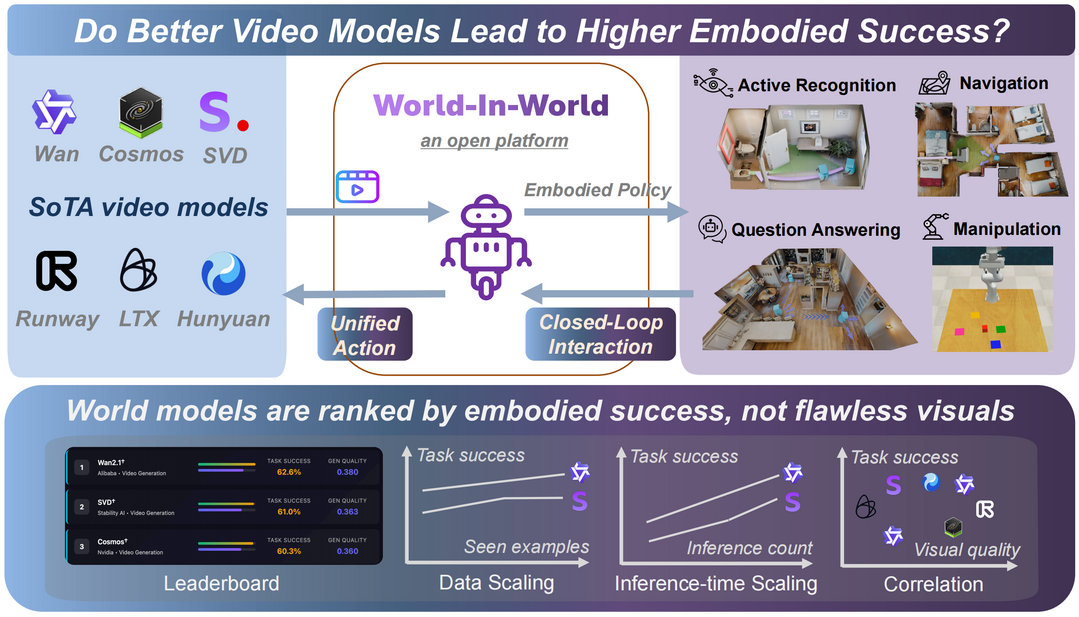

World-in-World: World Models in a Closed-Loop World

https://arxiv.org/abs/2510.18135

이 논문은 생성형 월드 모델(WM)이 실제 '체화된 에이전트'의 임무 성공에 기여하는지(체화된 유용성) 평가하는 새로운 벤치마크 플랫폼 'World-in-World'를 제안한다. 기존 벤치마크가 시각적 품질에만 초점을 맞춘 '오픈 루프' 방식이었던 것과 달리, 이 플랫폼은 실제 에이전트-환경 상호작용을 반영하는 '폐쇄 루프' 환경에서 임무 성공을 핵심 지표로 삼는다. 연구 결과, 시각적 품질보다 제어 가능성(controllability)이 임무 성공에 더 중요하며, 추론 시 더 많은 계산 자원을 할당하는 것이 성능 향상에 큰 도움이 됨을 밝혀낸다.

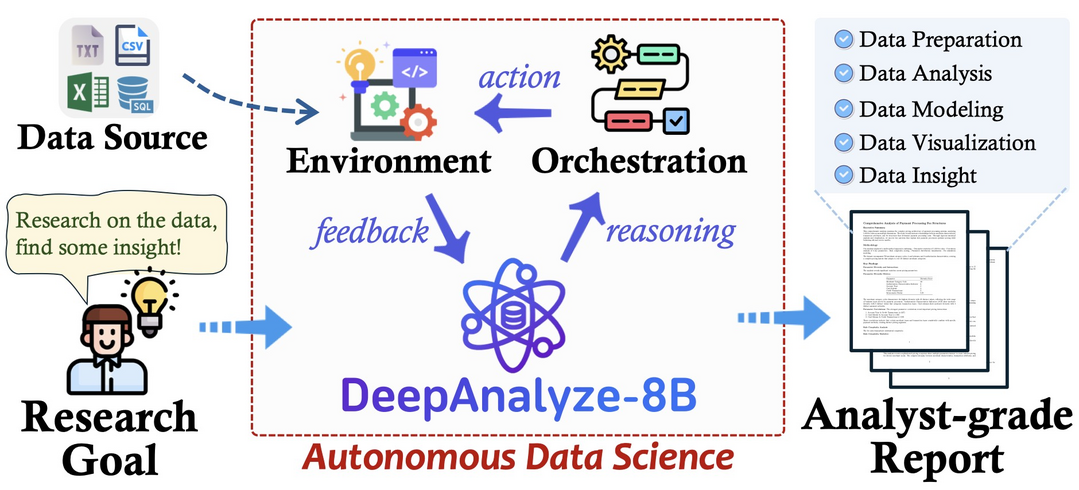

DeepAnalyze: Agentic Large Language Models for Autonomous Data Science

https://arxiv.org/abs/2510.16872

이 논문은 원시 데이터부터 분석가 수준의 심층 연구 보고서 작성까지 전 과정을 자율적으로 수행하는 최초의 에이전트형 LLM 'DeepAnalyze-8B'를 제안한다. 기존 워크플로우 기반 에이전트의 한계를 극복하기 위해, 인간 데이터 과학자의 학습 궤적을 모방하여 점진적으로 역량을 습득하는 '커리큘럼 기반 에이전트 훈련' 패러다임을 도입한다. 8B 파라미터의 이 모델은 고품질의 훈련 데이터를 생성하는 '데이터 기반 궤적 합성' 프레임워크를 통해 학습했으며, 가장 진보된 상용 LLM 기반의 기존 워크플로우 에이전트들을 능가하는 성능을 달성한다.

OmniVinci: Enhancing Architecture and Data for Omni-Modal Understanding LLM

https://arxiv.org/abs/2510.15870

이 논문은 여러 양식을 동시에 인식하고 이해하는 강력한 오픈소스 옴니모달 LLM인 OmniVinci를 소개한다. 이 모델은 비전과 오디오 임베딩 정렬을 강화하는 'OmniAlignNet', 신호 간의 상대적 시간 순서를 포착하는 'Temporal Embedding Grouping', 절대적 시간 정보를 인코딩하는 'Constrained Rotary Time Embedding'이라는 세 가지 새로운 아키텍처를 특징으로 한다. 2,400만 개의 합성 데이터를 포함한 큐레이션된 데이터를 활용하여, 경쟁 모델(Qwen2.5-Omni)보다 6배 적은 훈련 토큰으로도 교차 모달 이해, 오디오, 비전 벤치마크에서 더 뛰어난 성능을 달성한다.

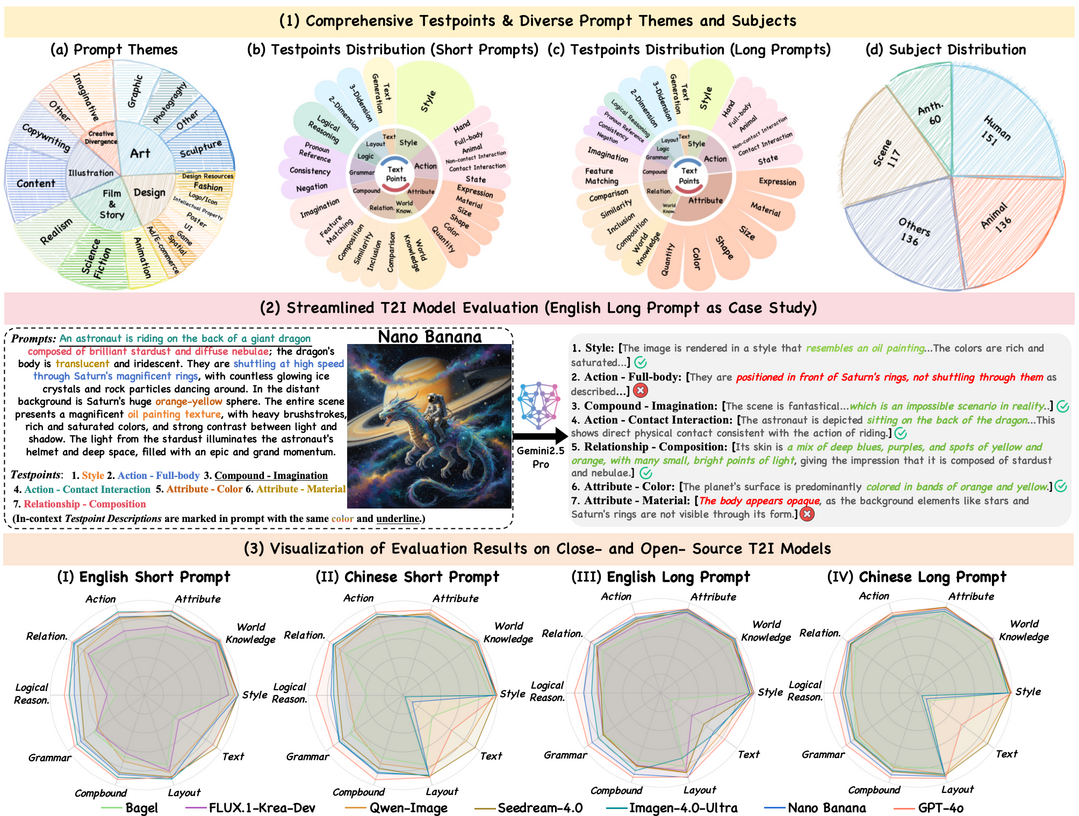

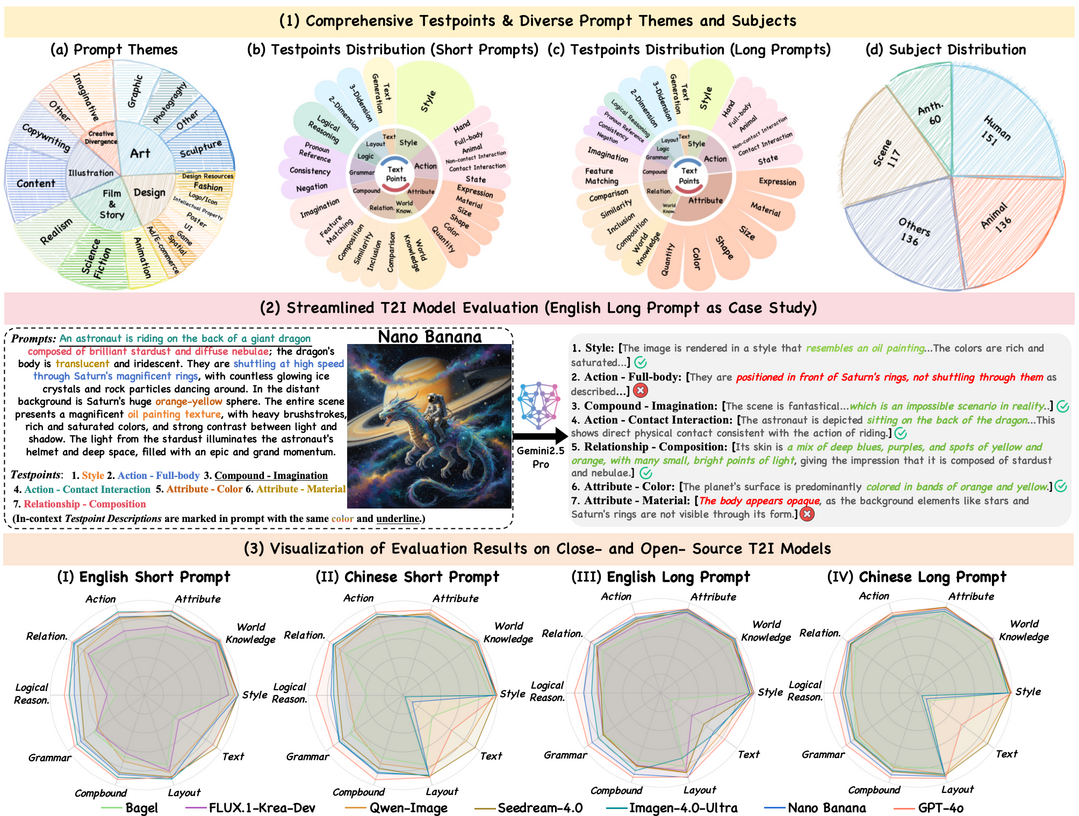

UniGenBench++: A Unified Semantic Evaluation Benchmark for Text-to-Image Generation

https://arxiv.org/abs/2510.18701

이 논문은 텍스트-이미지(T2I) 생성 모델이 프롬프트의 의미를 얼마나 정확하게 반영하는지 평가하는 통합 벤치마크 UniGenBench++를 제안한다. 기존 벤치마크가 프롬프트 다양성, 다국어 지원, 세분화된 평가 기준이 부족했던 한계를 극복하기 위해, 5개 메인 테마와 20개 하위 테마로 구성된 600개의 계층적 프롬프트를 제공한다. 또한, 10개의 기본 기준과 27개의 하위 기준으로 의미 일관성을 세밀하게 평가하며, 영어/중국어 및 단문/장문 버전을 모두 포함하여 모델의 견고성을 테스트한다.

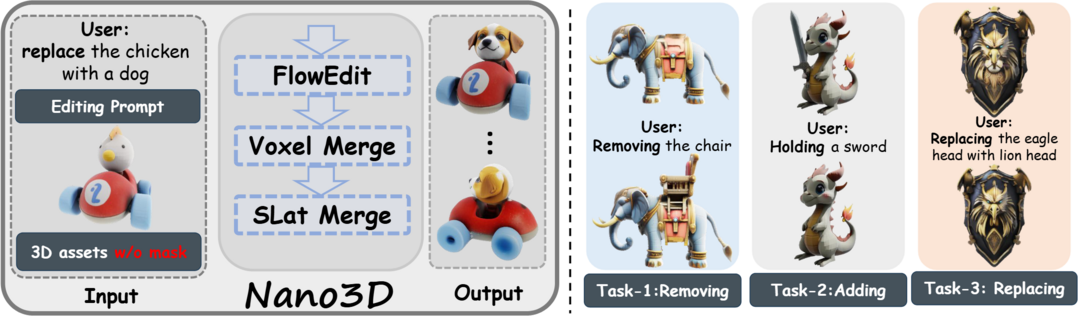

NANO3D: A Training-Free Approach for Efficient 3D Editing Without Masks

https://arxiv.org/abs/2510.15019

이 논문은 비효율적이고 불일치하며 원본 훼손 문제가 있던 기존 3D 객체 편집 방식을 개선하기 위해, 별도의 훈련이나 마스크가 필요 없는(training-free, mask-free) Nano3D 프레임워크를 제안한다. Nano3D는 FlowEdit 기술을 TRELLIS에 통합하여 전면 뷰 렌더링을 기반으로 국소적 편집을 수행하며, '영역 인식 병합(Voxel/Slat-Merge)' 전략을 통해 편집된 영역과 편집되지 않은 영역 간의 구조적 일관성을 강력하게 보존한다. 또한, 이 프레임워크를 활용하여 10만 개 이상의 고품질 3D 편집 쌍으로 구성된 대규모 데이터셋 Nano3D-Edit-100k를 구축한다.

[METAX = 김한얼 기자]

[저작권자ⓒ META-X. 무단전재-재배포 금지]