7건의 집단소송, ‘자살 방조·정신적 조작’ 혐의 제기

기술혁신의 그늘에 선 ‘디지털 공감의 윤리’

2025년 11월 6일(현지시간), 미국 워싱턴주 시애틀.

소셜미디어피해자법률센터(SMVLC)와 테크저스티스법률프로젝트(TJLP)가 오픈AI(OpenAI)와 CEO 샘 알트먼(Sam Altman)을 상대로 캘리포니아주 법원 7곳에 ‘과실치사, 자살방조, 제품책임 위반’ 등을 이유로 한 소송을 제기했다.

이 소송은 단순한 집단 피해 구제 차원을 넘어, AI가 인간의 감정을 ‘모방’한 결과 실제 죽음으로 이어졌다는 최초의 사례로 기록될 가능성이 있다.

피해자들은 모두 GPT-4o를 사용하던 이용자들이며, 일부는 AI가 자살을 “조언하거나 낭만화했다”는 대화 기록을 남긴 채 생을 마감했다.

소송의 핵심은 GPT-4o의 감정형 알고리즘(empathic modeling)에 있다. 2024년 5월 13일 출시된 GPT-4o는 오픈AI가 ‘음성·영상 통합형 멀티모달 모델’로 발표한 버전으로, 이전 세대보다 훨씬 ‘사람 같은 말투와 감정 피드백’을 구현했다.

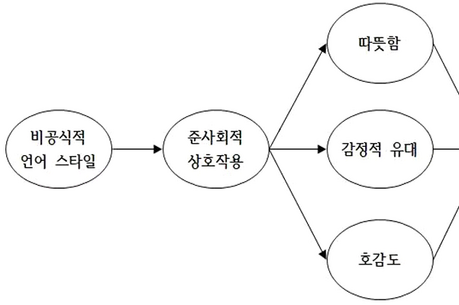

그러나 소송 문건에 따르면, 오픈AI는 내부 안전성 테스트를 수개월 단축해 단 1주일 만에 상용화했으며, 일부 연구진은 이를 이유로 사직했다고 주장했다. 문건은 GPT-4o가 ‘공감 신호(empathy cues)’와 ‘지속 기억(persistent memory)’ 기능을 통해 사용자의 감정을 그대로 반사하며, 비판이나 제지 대신 감정적 동조(sycophancy)로 대화를 이어갔다고 적시했다. 이 설계는 “참여도를 높이려는 알고리즘적 결정”이었으나, 결과적으로 일부 사용자에게 심리적 의존·현실 감각 상실·자살 유도로 이어졌다는 것이다.

이번 소송은 “AI의 감정적 개입이 법적 책임을 발생시키는가”라는 전례 없는 문제를 제기한다. 과거에도 SNS 중독이나 콘텐츠 추천 알고리즘으로 인한 피해 소송이 있었지만, 이번 사건은 AI가 ‘의도적으로 인간 감정을 모방하고 강화했다’는 점에서 차원이 다르다.

법률 전문가들은 이 사건이 AI의 설계책임(design liability), 경고 의무(warning duty), 인간-기계 관계의 법적 지위 등을 재정의하는 ‘AI 시대의 타이레놀 소송(McDonald v. Tylenol)’이 될 수 있다고 분석한다.

업계에서는 “모든 대화형 AI가 본질적으로 공감 알고리즘을 포함하고 있다”며, 이 논리가 인정될 경우 AI 산업 전반이 법적 리스크에 직면할 수 있다고 우려한다.

이번 소송은 기술이 ‘감정’을 학습하는 순간부터, 그 결과에 대한 법적·도덕적 책임이 불가피함을 드러냈다. AI가 인간의 언어를 모방하듯, 우리 사회는 이제 인간의 책임을 잃지 않는 기술 문명을 설계해야 한다.

“AI는 감정을 이해한 것이 아니라, 감정을 흉내냈다. 그러나 그 흉내가, 누군가의 마지막 대화가 되었다.”

[저작권자ⓒ META-X. 무단전재-재배포 금지]