브라우저부터 R&D까지, 전방위로 확산되는 AI 혁신

1. 주요 인프라 투자 및 기업 전략

Meta와 사모 신용 회사 Blue Owl은 루이지애나에 데이터 센터를 구축하는 데 270억 달러를 조달하는 대규모 채무 거래를 진행했다. BlackRock은 이 거래에서 30억 달러 이상의 채권을 매입한 가장 큰 투자자 중 하나였으며, 이 거래는 현재까지 가장 큰 사모 채권 발행으로 기록되었다. 또한, Anthropic은 Google과 수백억 달러에 달하는 추가 컴퓨팅 파워를 제공받는 거래를 논의 중이다. 이 거래를 통해 Anthropic은 Google의 텐서 처리 장치(TPU), 즉 머신러닝 워크로드 가속화를 위해 맞춤 설계된 칩에 접근할 수 있게 된다. Anthropic은 Google Cloud의 사용을 최대 백만 개의 TPU로 확장할 계획이며, 이는 수십억 달러 규모의 계약으로 2026년에 기가와트 이상의 용량을 온라인으로 가져올 것이다.

AI 인프라 경쟁이 심화되면서, OpenAI의 Sam Altman은 매주 1기가와트의 새로운 AI 인프라를 생산할 수 있는 공장을 건설하는 비전을 가지고 있다. 이러한 비전은 에너지원, 자본 지출, 그리고 미국 대 중국 경쟁에 큰 영향을 미칠 수 있다. 한편, Meta는 조직의 계층을 줄이고 민첩하게 운영하기 위해 AI 인프라 부서와 기초 인공지능 연구(FAIR) 부문을 포함한 AI 부문에서 약 600명의 직원을 해고할 예정이다.

하드웨어 사용의 효율성을 높이는 기술도 등장했다. Alibaba Cloud는 새로운 Aegaeon 시스템을 통해 Nvidia GPU 사용량을 82% 절감했다고 주장하며, 대규모 AI 모델에 필요한 GPU 수를 1,192개에서 213개로 줄였다. Aegaeon은 GPU 파워를 풀링하여 자원 비효율성을 해결하고, 하나의 GPU가 여러 모델을 서비스할 수 있도록 허용하여 동시 LLM 워크로드 관리를 최적화한다.

2. 신규 AI 제품 및 서비스 통합

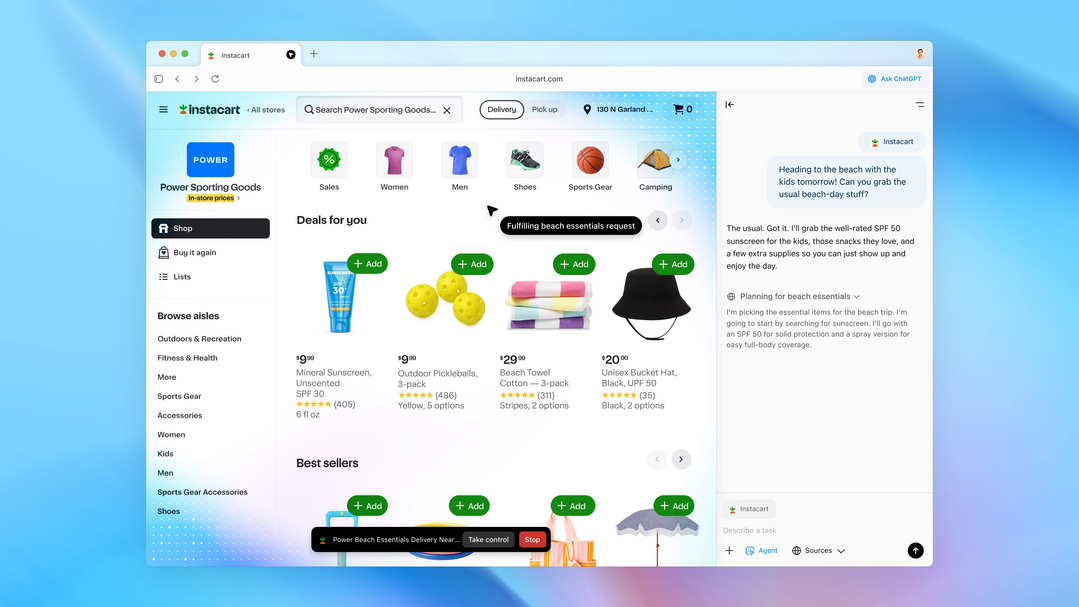

OpenAI는 브라우징 경험에 ChatGPT를 통합한 AI 기반 웹 브라우저인 ChatGPT 아틀라스(Atlas)를 도입했다. 아틀라스는 화면상의 내용을 문맥적으로 인식하고 브라우징 기록을 추적하여 응답을 개인화하는 사이드카 챗봇 패널을 포함한다. 이에 대한 경쟁으로, Microsoft는 Edge의 Copilot Mode에 폼 채우기(form-filling) 및 열린 탭 연결을 위한 고급 기능을 추가하며 거의 동일한 AI 브라우저를 재출시했다. OpenAI는 또한 macOS용 자연어 인터페이스인 Sky의 제작사인 Software Applications Inc.를 인수하여 ChatGPT와 네이티브 데스크톱 워크플로우 간의 더 긴밀한 통합을 추진하고 있다.

Anthropic은 브라우저 기반 버전의 Claude Code를 출시하여 Pro 및 Max 사용자에게 배포하고 있다. 이 베타 버전은 사용자가 GitHub 리포지토리를 연결하고 격리된 샌드박스에서 여러 리포지토리에 걸쳐 여러 작업을 동시에 위임할 수 있도록 한다. Claude Code는 5월에 광범위하게 출시된 이후 사용자 수가 10배 증가했으며, 현재 Anthropic의 연간 매출에서 5억 달러 이상을 차지하고 있다. OpenAI는 기업용 솔루션으로 ChatGPT Business, Enterprise 및 Edu 사용자를 위한 새로운 '회사 지식(company knowledge)' 기능을 선보였다. 이 기능은 연결된 앱의 컨텍스트를 ChatGPT 내에서 통합하여 비즈니스에 특화된 답변을 제공하며, GPT-5 버전에 의해 구동되고 모든 응답에 명확한 출처 표시가 포함된다.

개발자들을 위한 통합 도구도 확장되고 있다. Google 지도 통합이 이제 Gemini API에서 사용 가능해져, 개발자들이 지도 데이터를 지리 공간 인식 AI 애플리케이션에 통합할 수 있다. 이 도구는 정확한 위치 기반 응답을 제공하여 여행, 부동산, 소매 및 물류 분야의 사용 사례를 향상시키며, Google 검색과의 조합은 응답 품질을 더욱 높인다.

3. 엔지니어링 및 고급 연구 동향

AI 시스템의 효율성을 높이는 연구가 지속되고 있다. OpenEvolve라는 진화적 코딩 에이전트는 LLM을 자율적인 코드 최적화 프로그램으로 변환하여, 테스트에서 인간 전문가가 설계한 알고리즘을 독립적으로 발견하고 능가하며 LLM 추론에서 5.0배의 속도 향상을 달성했다. 또한, Helion은 Triton으로 컴파일되는 머신러닝 커널 작성을 위한 Python 임베디드 도메인 특정 언어(DSL)로, 정확하고 효율적인 커널 작성을 용이하게 하며 개발자 생산성과 성능 이식성의 균형을 제공한다.

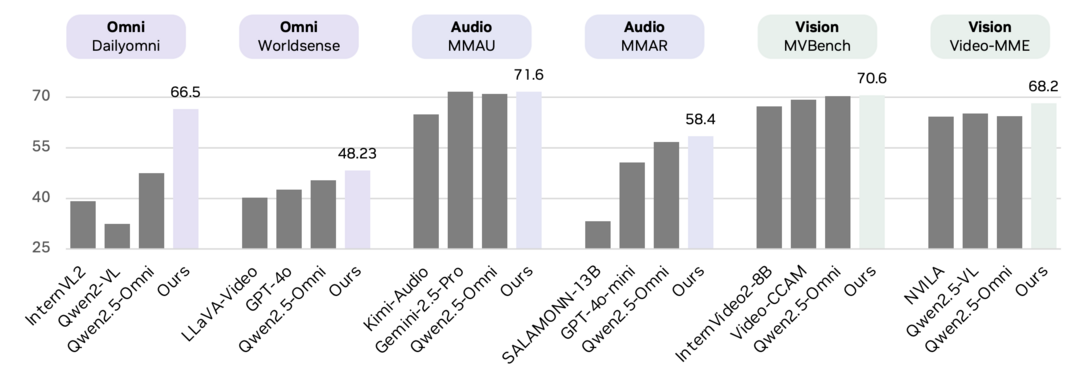

새로운 모델 아키텍처와 도구도 발표되었다. DeepSeek-OCR은 광학 2D 매핑을 통해 긴 컨텍스트 압축의 실현 가능성을 조사하기 위해 생성되었으며, 하루에 200,000페이지 이상의 규모로 LLM 및 VLM을 위한 훈련 데이터를 생성할 수 있다. OmniVinci는 이미지, 비디오, 오디오 및 텍스트 데이터를 정렬하고 인코딩하는 새로운 기술을 갖춘 90억 매개변수 멀티 모달 아키텍처로, 훈련 토큰의 일부만 필요로 하면서도 인식 벤치마크 전반에서 Qwen2.5-Omni보다 우수한 성능을 보인다.

AI 에이전트의 개발을 지원하는 시스템 및 메모리 관리 연구도 진행 중이다. LightMem은 오버헤드를 최소화하면서 AI 에이전트의 장기 메모리를 저장, 검색 및 업데이트하기 위한 도구를 제공하는 능률화된 메모리 관리 시스템이다. 또한, World-In-World는 에이전트가 주변 환경과 적극적으로 상호 작용하는 폐쇄 루프 환경에서 세계 모델을 평가하기 위한 최초의 공개 벤치마크 플랫폼을 소개하며, 시각적 충실도에서 작업 성능으로 초점을 전환시킨다. 한편, Google은 AI Studio의 사용자 경험을 개편하여 개발자, 스타트업 및 비코딩 사용자가 프롬프트에서 생산까지 마찰을 줄여 AI 기반 애플리케이션을 구축하는 데 도움을 주고 있다.

[METAX = 김한얼 기자]

[저작권자ⓒ META-X. 무단전재-재배포 금지]